图1 迁移学习过程示意图

张椰1,朱卫纲2

( 1.航天工程大学研究生院, 北京 101416; 2.航天工程大学光电装备系, 北京 101416)

摘要:针对深度卷积神经网络训练需要大数量样本,采用迁移学习的方法辅助网络训练,解决了SAR图像样本不足的问题。通过控制对比实验,对每个卷积块权重进行迁移与分析,使用微调与冻结相结合的训练方式有效提高网络的泛化性与稳定性;然后根据目标检测任务的时效性对网络模型进行改进,提高了网络检测速度的同时减少了网络参数;最后结合复杂场景杂波切片对网络进行训练,降低了背景杂波的虚警目标数量,复杂多目标场景的检测结果表明所提出方法具有较好的检测性能。

关键词:迁移学习; 深度卷积神经网络; SAR目标检测; 训练时间

近年来,合成孔径雷达(Synthetic Aperture Radar,SAR)在军事和民用领域的应用越来越广泛,需要处理的SAR的数据量也越来越多,这使得对SAR图像处理与解译技术的需求更加迫切。SAR图像解译的一个主要应用是围绕如何从含有背景杂波的图像中检测地面机动目标[1-2],如坦克、车辆、飞机等。

当前深度卷积神经网络(Deep Convolutional Neural Network,DCNN)在图像处理领域取得了较好的结果,借鉴光学图像的成功应用,深度卷积网络在SAR目标分类开展了一些研究并取得了不错的成果[3-4],但在SAR目标检测中才处于起步阶段,尤其是当训练样本数量有限情况下对复杂场景多目标检测还存在一定的难度。首先,DCNN往往需要大数据来驱动,利用大量已标注的图像样本进行有监督的训练,目前虽然存在如Imagenet[5],Pascal VOC[6]等大型通用图像数据集,但对于一些特定领域的图像数据集,样本数量仍然不足以驱动DCNN的训练与学习;其次,由于DCNN需要训练的参数数量十分庞大,即便使用GPU加速也会花费较长的训练时间,同时网络的训练技巧与方法需要依靠经验和大量的调试。针对上述两个问题,学者提出了迁移学习的方法[5-8],通过把在大型通用数据集上预训练得到的网络和参数迁移并应用到新的领域,有效解决了DCNN在小样本条件下的训练样本不足问题,同时大幅度减少网络的训练开销,使得DCNN的应用领域更加广泛。Zeiler等[7]利用ImageNet预训练后的网络在Caltech-101进行迁移训练和测试,使得图像分类精度提高了40%。Kang等[8]利用CIFAR-10预训练的网络提高了该网络在TerraSAR数据集上的分类精度。除了迁移学习的直接应用,Yosinski等[9]还对卷积神经网络不同层次特征的迁移学习效果进行了探索。Zhou等[10]提出不同领域的相关性对卷积神经网络的迁移学习具有一定的影响。

上述迁移学习方法在各自领域获得了成功应用,但对于不同的源域和目标域之间,迁移的方式和技巧会有所差异,尤其是图像特点之间的差异较大时。借鉴上述迁移学习的经验,本文针对SAR目标检测网络训练样本不足的问题,利用迁移学习方法将Pascal VOC数据集上预训练的网络和权重参数辅助检测网络的训练。考虑到领域的相关性,本文逐层对每个卷积块的权重进行迁移与分析,并通过不同的训练方式使得源域任务更好地拟合目标域任务。同时根据SAR目标检测任务的需求,对迁移网络进行改进,降低网络的训练时间和网络参数数量。

近年来,迁移学习引起了广泛的关注和研究,在维基百科中的定义是:迁移学习是运用已存有的知识对不同但相关领域问题进行求解的一种新的机器学习方法。在卷积神经网络中其训练所获得的知识体现于网络的权重参数中,而卷积神经网络体系结构的一个优势是经过预训练的网络模型可以实现网络结构与网络权重的分离,并分别以配置文件的方式进行保存,只要迁移的网络结构不改变,就可以利用在大型数据集上训练好的权重参数初始化目标网络,这一特点极大地提高了网络模型和权重(知识)迁移的可操作性。

在迁移学习中,有两个概念:域(Domains)和任务(Task)。一个域D可以表示为D=X,PX,其中X是特征空间,PX是基于X的边缘概率分布,X={X1,X2,…,Xn}∈X。一般来说,两个不同的域的特征空间或概率分布是不一样的。给定一个域D=X,PX,任务可以表示为T={Y,f(·)},其中Y是标签空间,f(·)是预测函数,可以通过训练集{xi,yi}学习而来,xi∈X,yi∈Y。从概率论的角度来看,fx相当于Py|x,即输入x被预测为各类的概率。迁移学习一般涉及两个域:源域(Source Domain)DS和目标域(Target Domain)DT,因而迁移学习可以定义为:给定一个源域DS和学习任务DT,一个目标域DT和学习任务TT,迁移学习的目的是使用DS和TS中的已有知识,其中DS≠DT和TS≠TT,帮助提高目标域DT中目标预测函数f(·)的学习,即完成目标域任务TT。

作为一种新的机器学习方法,迁移学习与传统的机器学习方法相比,主要存在3个方面的优势[11]:一是不要求训练数据与测试数据满足独立同分布的条件;二是不需要足够的训练样本就能学习到一个好的分类模型;三是不需要对每个任务分别建模,可以重用之前任务的模型。

1.2.1 网络模型迁移

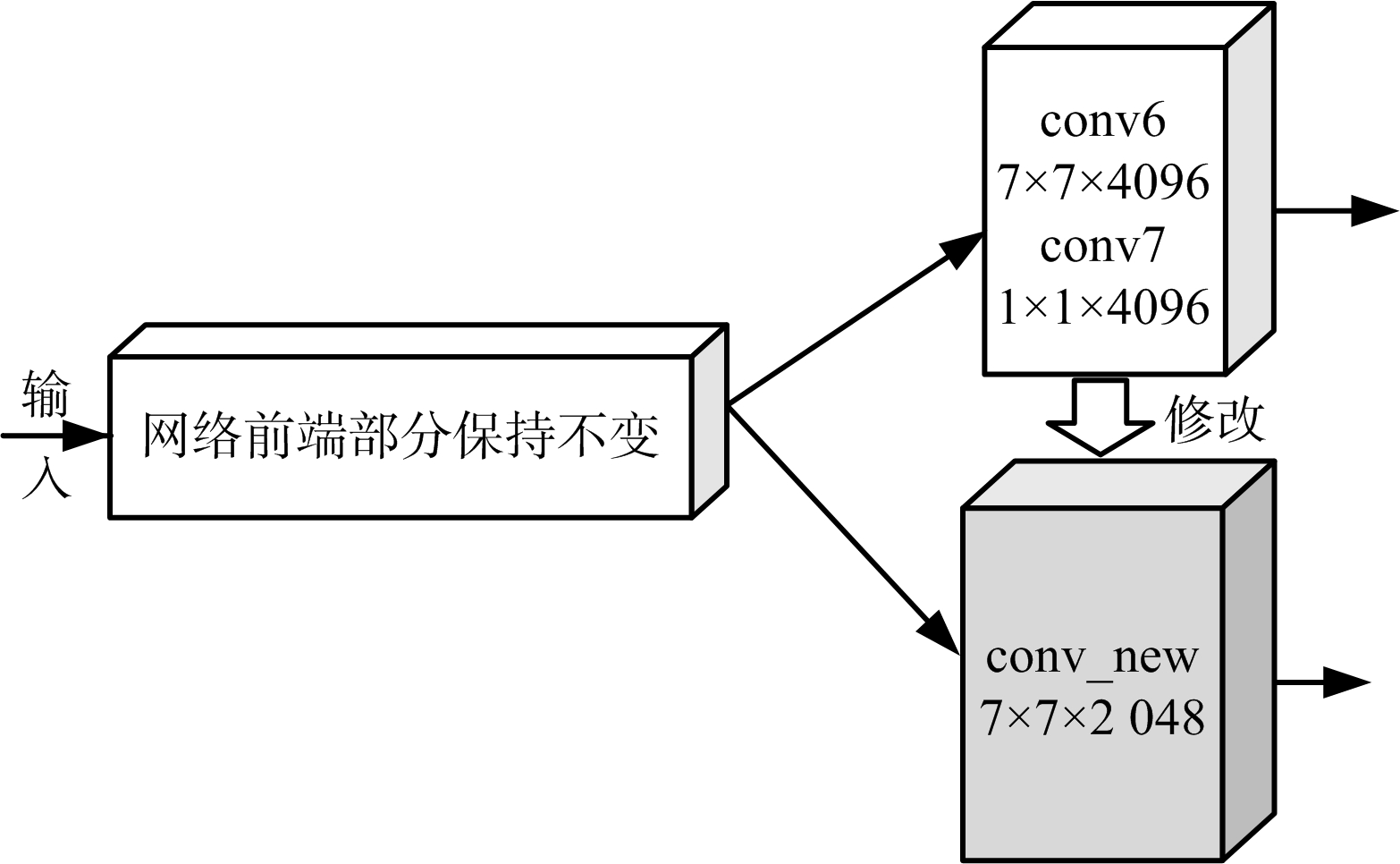

本文中SAR目标检测网络采用基于VGGNet网络模型的FCN-8[12],该网络在Pascal VOC数据集中实现对20类不同目标的像素分类,检测出的目标具有较好的区域整体性和边缘轮廓性,因此本文对其网络进行迁移用于SAR图像的二值检测,迁移学习过程如图1所示。由于源域任务TS中涉及的像素类别有21类,目标任务TT中SAR图像像素类别只有2类,因而对迁移的网络模型的输出端进行修改,分类器只需对像素是否为目标进行判别。

图1 迁移学习过程示意图

1.2.2 网络权重迁移与训练

网络权重迁移要求源域DS的网络结构和目标域DT一致时才能进行迁移,对于修改部分的网络权重采用随机初始化;同时根据源域任务与目标任务之间的差异,可以只对网络前端的部分层权重进行迁移,具体迁移多少层的权重最符合目标任务的需求需要通过实验来验证。

迁移权重对网络参数进行初始化后,网络对迁移权重训练时有微调和冻结[9]两种方式。微调时反向传播经过所有层,会对所有层的权重进行调整;而冻结时不进行反向传播,迁移层权重始终保持不变,只对未迁移的层进行训练;同样可以根据目标任务的特点将两种方式进行结合。具体训练方式如图2所示。具体使用哪一个方式需要考虑学习任务之间的相关性,当迁移领域比较接近的情况,为了避免网络的过拟合,往往采用冻结权重训练的方式;当迁移领域差异较大时,微调训练方式能使源域知识更好拟合目标任务的需求。

图2 迁移权重再训练方式示意图

深度卷积网络通过增加网络层数能有效地提高分类器的精度,同时也增加了网络训练的开销。文献[13]指出网络训练时间主要消耗在卷积层,全连接层和池化层计算时间占总时间的5%~10%,其中卷积操作的时间复杂度表示如下:

式中,d为网络卷积层的总层数,nl为本层特征图个数,nl-1为上一层特征图个数,也可以称作nl层的输入通道数,sl为filter的尺寸,ml为输出特征图的尺寸。上述时间复杂度只是理论上的,真实的计算时间和部署方式、硬件有一定的关系。

考虑学习任务之间的相关性,SAR目标检测网络的像素类别只有2类,对分类器进行训练时所需要的特征组合不需要光学图像那么多,因此本文对conv6和conv7替换,替换为conv_new,具体修改如图3所示。可以看出,conv_new首先将conv6的特征图的数量减少了一半,其次由于conv7卷积操作未改变特征图的大小,直接将其删除,修改后的网络减少了网络训练和测试的时间,提高了检测的时效性,其次也大大减少了网络需要存储的参数数量,降低了对硬件的要求。

图3 检测网络的改进

本文数据集来自MSTAR数据库,目前国内外对SAR图像地面目标进行的研究也大多以该数据集作为实验数据。该数据集包含大量地面目标切片和少量大场景杂波图像。

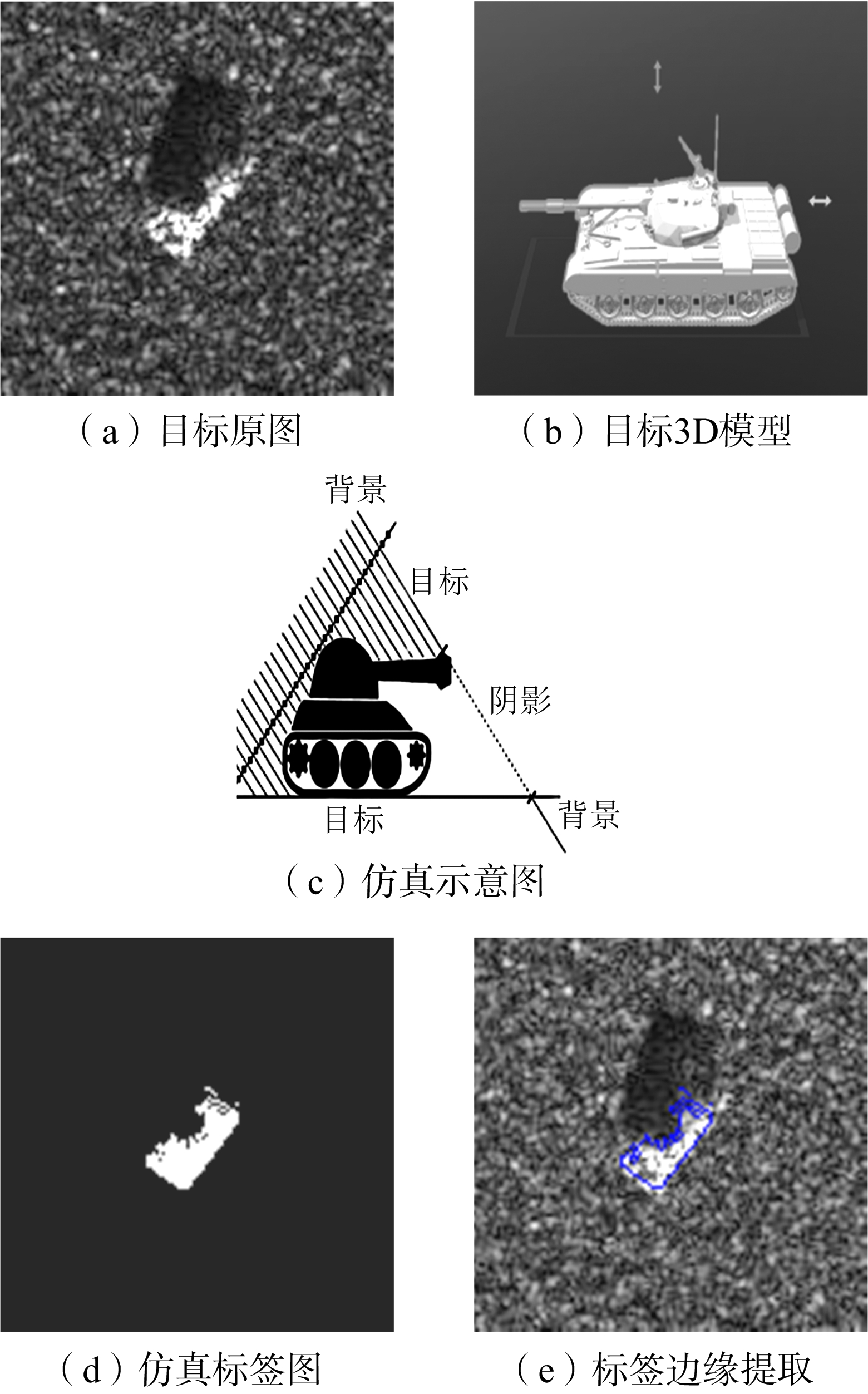

制作标签样本时,需要对目标像素进行标记,不同于光学图像的标记,SAR图像受相干斑噪声等成像机制的影响,目标、阴影与背景区域之间的过渡区域很难分离,对其进行手工标注具有很大的主观性和随机性。本文利用MSTAR目标的3D模型进行成像仿真[14],利用真实目标切片获取的俯仰角和方位角信息对目标模型进行仿真,生成三维目标对应的二维图像,得到目标所在区域,从图4展示的BMP2(装甲车)目标切片的仿真标注结果来看,仿真结果能较好地与实测数据拟合,因而采用仿真结果作为实测目标切片的标签数据。

图4 SAR目标标签仿真过程

根据实验需求,在网络的训练阶段设置两个数据集,分别对应不同的实验,其中数据集二只在复杂场景多目标检测实验中采用,各数据集具体说明如下:

数据集一:采用MSTAR数据集中目标切片样本,其中训练集包含有1 285张BMP2目标在15°和17°俯仰角下采集的图像,验证集为495张BTR70目标在15°和17°俯仰角下采集的图像,图像大小都为128×128像素。

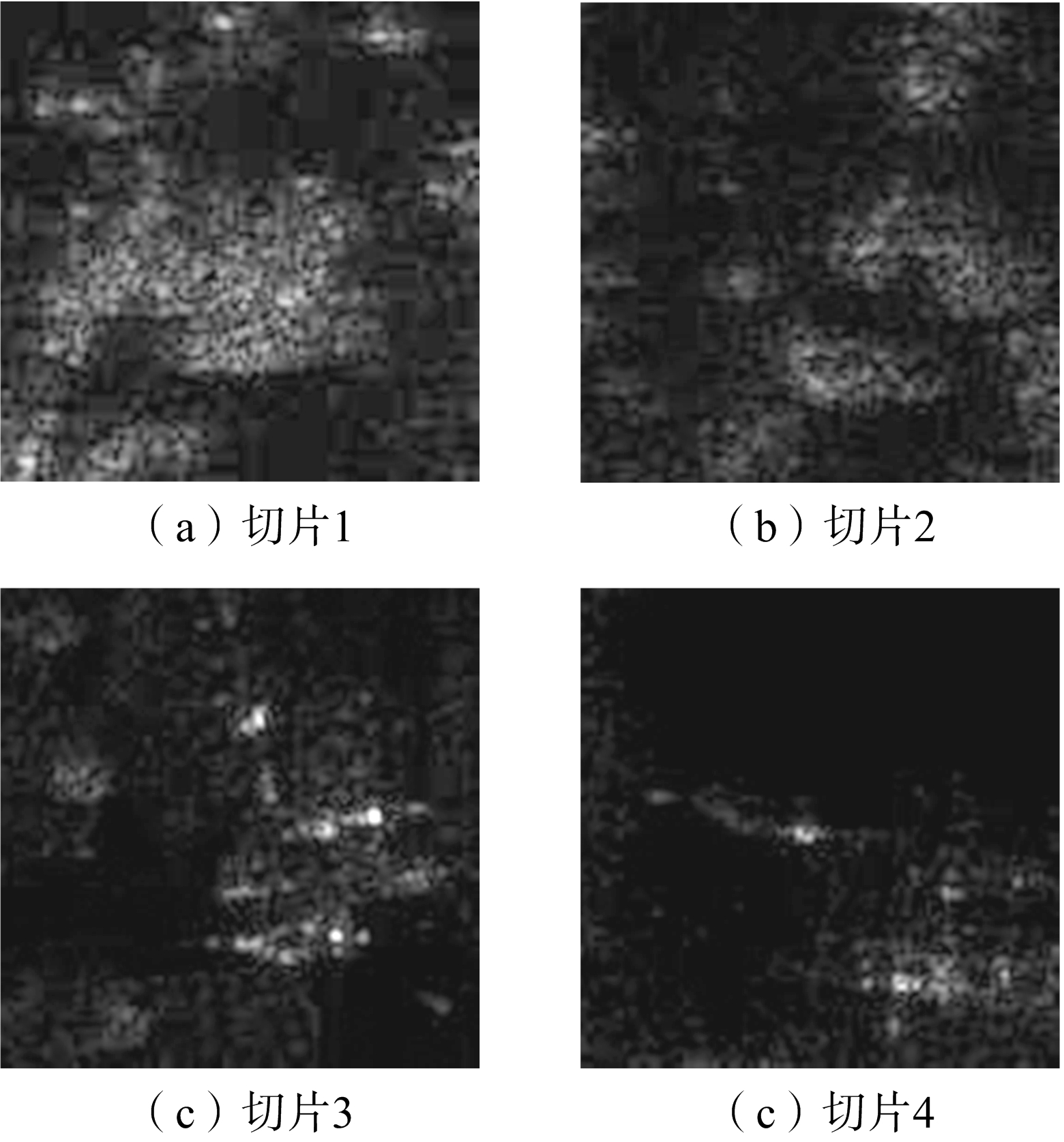

数据集二:在数据集一的基础上进行扩充,对MSTAR数据集中复杂场景(1 487×1 784大小)随机裁剪与目标切片大小一致的背景切片作为负样本,共400张,如图5所示,分别在数据集一的训练集和验证集中加入360张和40张。

图5 MSTAR复杂场景切片图

在实验训练与验证阶段,评价指标采用FCN中的候选区域重和度 (mean_IU),用正确分类的候选区域(R)与实际区域(R′)的交集除以候选区域像素面积与实际区域面积之和得到的交并比:

mean_

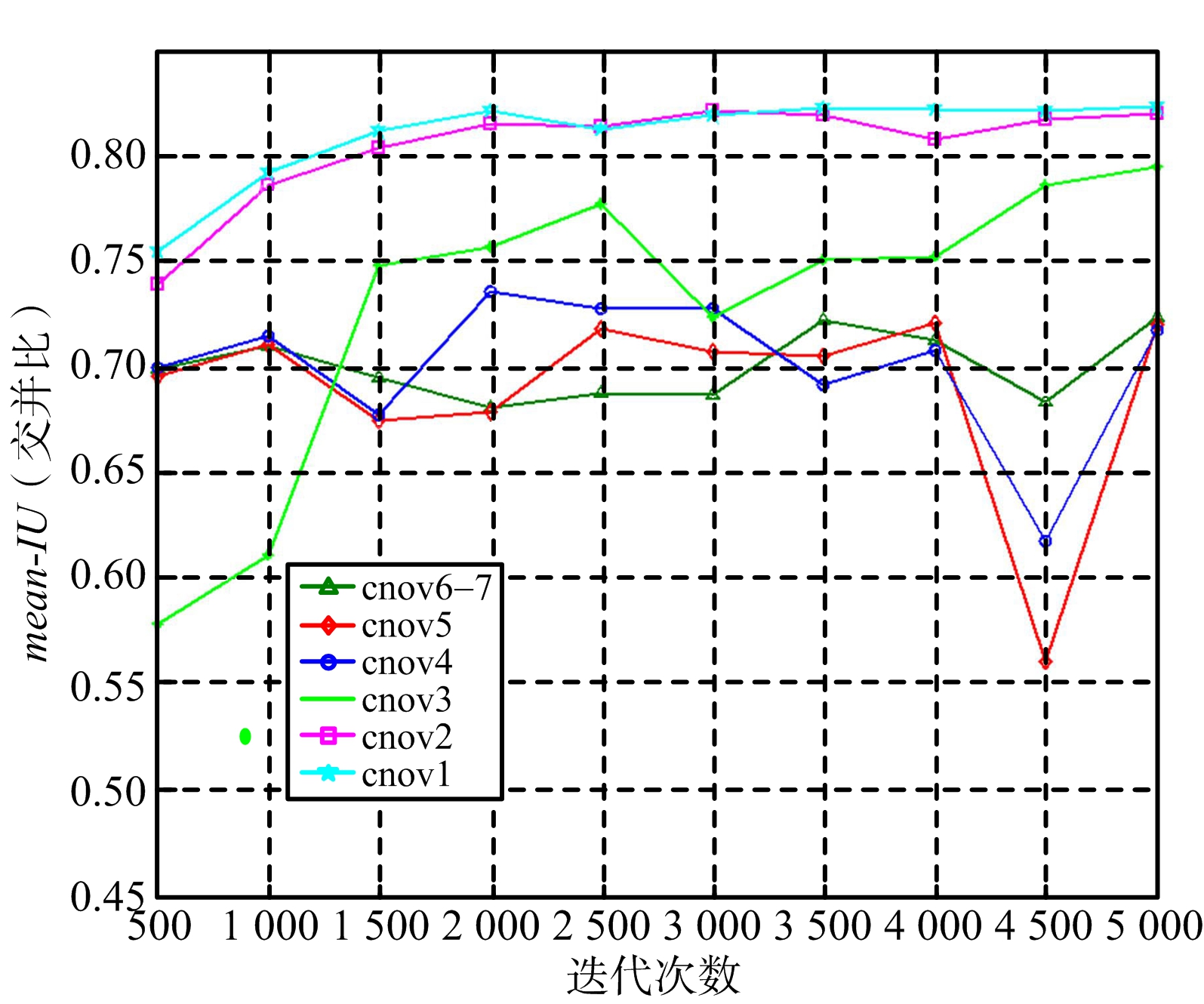

实验中每次训练统一迭代5 000次,每迭代500次对验证集进行一次验证。实验使用的硬件平台为CPU:Intel i7-7700 K@4.x20 GHz,GPU:GTX TITAN X。此处的GPU主要强调图形加速器功能,用于网络训练过程中并行化处理,CPU和GPU之间并不冲突和矛盾。

2.2.1 迁移网络与训练方式实验结果与分析

在对检测网络进行训练时,本实验对迁移的权重分别采取冻结、微调、冻结与微调结合三种训练方式进行实验。具体实现说明如下:

1) 冻结:依次对conv1~conv6-7权重进行迁移,训练时保持迁移权重固定不变;

2) 微调:依次对conv1~conv6-7权重进行迁移,训练时采用反向传播算法对迁移权重进行微调;

3) 冻结与微调结合:首先将conv1~conv6-7全部权重进行迁移,然后依次从conv1~conv6-7冻结权重,未冻结的层采用反向传播进行微调。

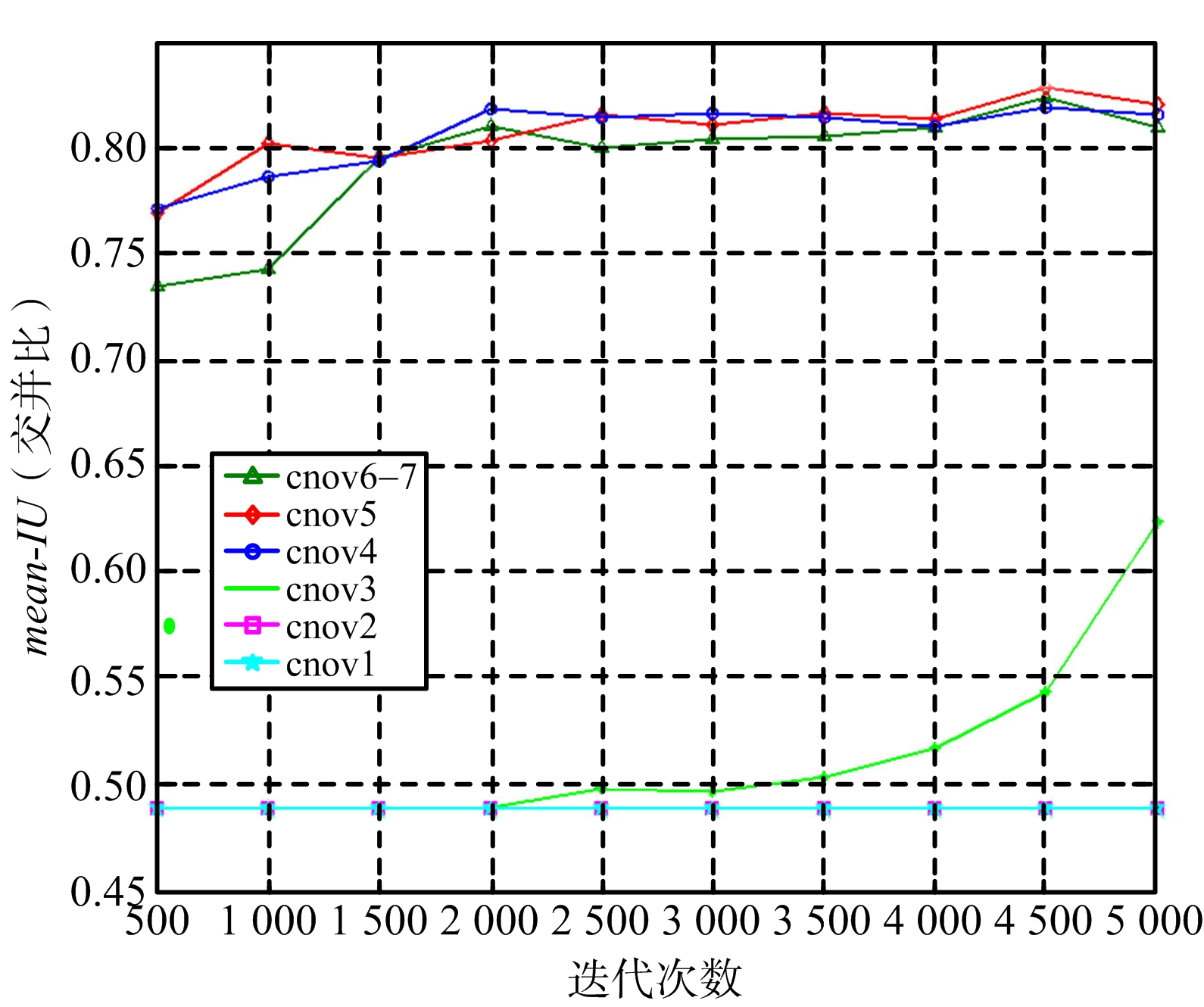

分别利用以上3种方式对网络进行训练,其训练时的验证结果如图6所示。采用训练结束后的权重对验证集进行5次验证,并取5次结果的平均值,其结果如图7所示。根据实验结果可以得出以下结论:

1) 卷积网络从各层提取到的图像特征的表示能力逐步加强,conv1和conv2提取的浅层特征更具一般性与通用性,迁移的权重对目标任务的实现没有帮助;conv3~conv5提取的为深层特征,迁移的权重有利于目标任务的完成,其中conv4和conv5提取的高级特征能捕获更复杂的模式,这些模式一般只对训练集有效,对其他数据集并不具有泛化能力,对目标任务的贡献更加明显;对于conv6-7的迁移,在微调训练中反而使得精度下降了。

2) 由于目标数据集(SAR图像)与源域数据集(光学图像)的差异较大,而且像素分类类别也不一样,微调方式比冻结方式能更好地拟合目标域数据集的特点,而且微调方式得到的权重参数在验证集上的5次结果波动更小,更有利网络测试的稳定性。

(a) 冻结权重训练

(b) 微调权重训练

(c) 冻结与微调结合权重训练

图6 不同迁移方式训练结果对比

图7 5次验证结果及其平均值

3) 冻结和微调结合方式对浅层权重进行冻结,对中高层进行微调,取得效果更佳,可以认为源域数据集提取的浅层特征具有较好的泛化能力,冻结浅层权重可以有效避免网络的过拟合。由于深层特征更接近目标任务,所以需要根据目标域数据集特点进行微调。

2.2.2 改进的检测网络实验结果与分析

根据对网络训练方式的实验结果的分析,利用图3改进的网络进行训练时,冻结conv1和conv2的权重,微调conv3~conv5的权重,随机初始化conv_new的权重。同时对未改进的网络进行对比实验,其中冻结conv1和conv2的权重,微调conv3~conv5的权重,随机初始化conv6-7。为进一步验证改进网络的有效性,对2.2.1节中不同训练方式的最佳结果进行对比,实验结果如表1所示,检测结果如图8所示。结果表明,改进的网络在保证检测准确度的同时,减少了网络的训练时间和网络参数,提高了检测的时效性。目标检测能较准确获得目标区域,没有检测出孤立点,避免了后续的形态学处理,简化了检测的流程。

表1不同迁移方式最佳结果对比

图8 检测结果对比

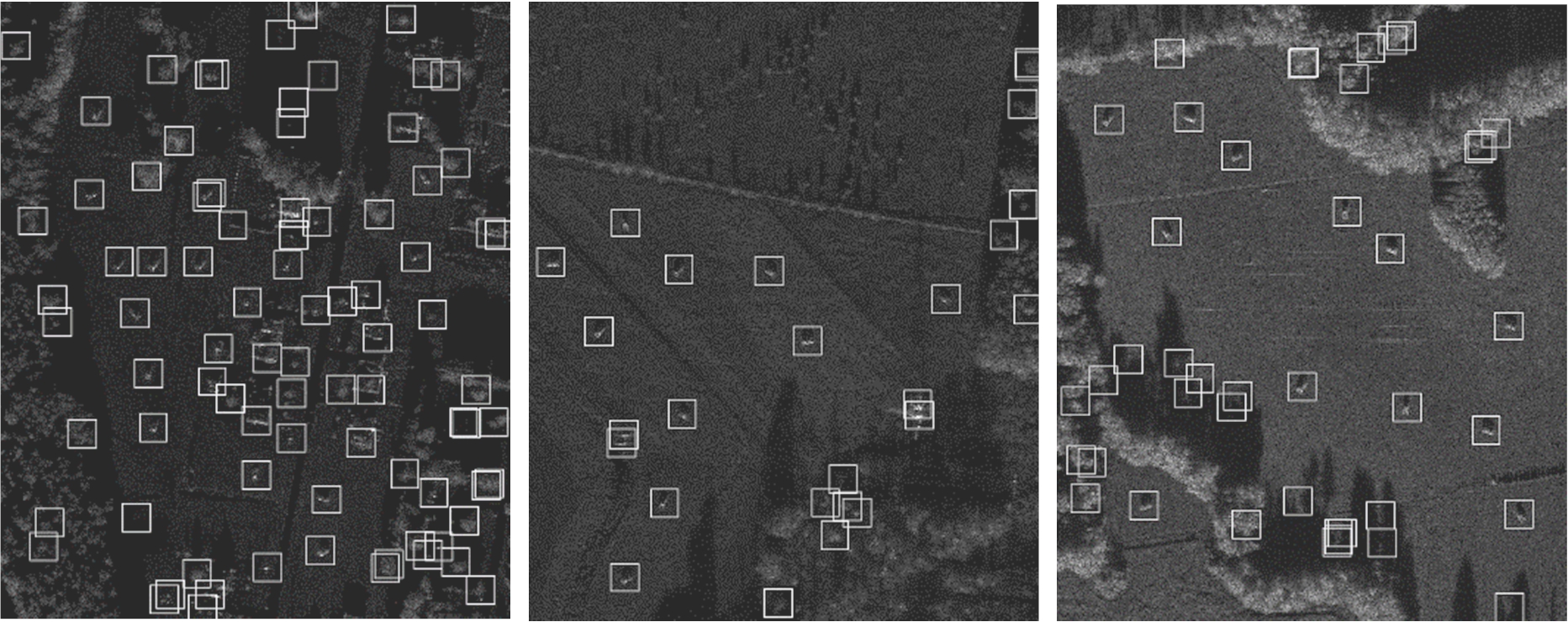

2.2.3 复杂场景多目标检测实验结果与分析

在MSTAR数据集包含的复杂大场景图像中,由于背景杂波对目标检测的干扰,采用数据集二对改进的检测网络重新进行训练,训练过程采用迁移学习中最佳的训练方式,其他实验条件保持不变。利用训练得到的检测网络对3幅不同场景图像进行二值检测,对检测的结果剔除面积小于25个像素点的区域,然后利用Matlab中rectangle函数定位到目标位置以及设置区域大小为80×80像素,检测结果如图9所示。

(a) 场景一 (b) 场景二 (c) 场景三

图9 复杂场景多目标检测结果

为进一步验证本文方法的有效性,采用经典的双参数CFAR检测算法进行对比,检测时保护窗设置为30,滑动窗为40,虚警率设置原则是在保证目标全部检测(检测率100%)的同时将虚警率设置得尽量小,阈值检测后利用形态学的腐蚀、膨胀以及面积阈值去除杂波虚警,检测结果如图10所示。从检测结果可以看出,CFAR在保证目标检测的同时出现了较多的虚警目标,主要原因是CFAR算法只利用了像素的强度信息,而没有考虑目标的结构信息,使得检测时对强散射区域尤其敏感。CFAR与本文方法对比结果如表2所示,对比结果进一步验证了检测网络在复杂场景多目标检测的有效性与鲁棒性。

表2本文方法与CFAR检测结果的对比

(a) 场景一 (b) 场景二 (c) 场景三

图10 双参数CFAR检测结果

本文引入迁移学习的方法解决了深度卷积神经网络在SAR目标检测网络训练数据集样本不足的问题,利用对比实验确定目标域迁移权重的训练方式,针对SAR目标检测的时效性对网络进行了改进,在单个简单背景目标检测的基础上,在训练集中引入复杂背景杂波切片,使得检测网络有效学习到背景杂波的先验信息,从而在多目标检测中有效避免了杂波的干扰。与CFAR方法相比,降低虚警率的基础上避免了人工参数的设置与后续形态学处理,简化了检测的流程,为下一步利用检测到的目标进行识别打下基础。

参考文献:

[1] 袁湛,何友,蔡复青.一种多目标环境下的SAR图像自适应CFAR检测方法[J].中国图象图形学报,2011,16(4):674-679.

[2] 高贵.SAR图像目标ROI自动获取技术研究[D].长沙:国防科学技术大学,2007.

[3] CHEN S,WANG H,XU F,et al.Target Classification Using the Deep Convolutional Networks for SAR Images[J].IEEE Trans on Geoscience and Remote Sensing,2016,54(8):4806-4817.

[4]刘晨,曲长文,周强,等.基于CNN的SAR图像目标分类优化算法[J].雷达科学与技术,2017,15(4):362-367.

[5] DENG J,DONG W,SOCHER R,et al.Imagenet:A Large-Scale Hierarchical Image Database[C]∥ IEEE Conference on Computer Vision and Pattern Recognition,Miami,FL:IEEE,2009:248-255.

[6] EVERINGHAM M,ESLAMI S M A,VAN GOOL L,et al.The Pascal Visual Object Classes Challenge:A Retrospective[J].International Journal of Computer Vision,2015,111(1):98-136.

[7] ZEILER M D,FERGUS R.Visualizing and Understanding Convolutional Networks[C]∥ European Conference on Computer Vision,Switzerland:Springer,2014:818-833.

[8] KANG Chenyao,HE Chu.SAR Image Classification Based on the Multi-Layer Network and Transfer Learning of Mid-Level Representations[C]∥ IEEE International Geoscience and Remote Sensing Symposium,Beijing:IEEE,2016:1146-1149.

[9] YOSINSKI J,CLUNE J,BENGIO Y,et al.How Transferable are Features in Deep Neural Networks?[C]∥ Advances in Neural Information Processing Systems,Montreal,Canada:[s.n.],2014:3320-3328.

[10] ZHOU B,LAPEDRIZA A,XIAO J,et al.Learning Deep Features for Scene Recognition Using Places Database[C]∥ Advances in Neural Information Processing Systems,Montreal,Canada:[s.n.],2014:487-495.

[11] 庄福振,罗平,何清,等.迁移学习研究进展[J].软件学报,2015,26(1):26-39.

[12] LONG J,SHELHAMER E,DARRELL T.Fully Convolutional Networks for Semantic Segmentation[C]∥ IEEE Conference on Computer Vision and Pattern Recognition,Boston,MA:IEEE,2015:3431-3440.

[13] HE K,SUN J.Convolutional Neural Networks at Constrained Time Cost[C]∥ IEEE Conference on Computer Vision and Pattern Recognition,Boston,MA:IEEE,2015:5353-5360.

[14] MALMGREN-HANSEN D,NOBEL-JORGENSEN M.Convolutional Neural Networks for SAR Image Segmentation[C]∥ IEEE International Symposium on Signal Processing and Information Technology,Abu Dhabi:IEEE,2015:231-236.

ZHANG Ye1,ZHU Weigang2

(1.GraduateSchool,SpaceEngineeringUniversity,Beijing101416,China; 2.DepartmentofOpticalandElectronicEquipment,SpaceEngineeringUniversity,Beijing101416,China)

Abstract:To solve the problem that the training of deep convolution neural network requires a large number of samples,the transfer learning method is used to assist the small SAR image dataset for network training.By contrast experiments,the individual convolution weights are transferred and analyzed.The combination of the fine-tuned weights and the frozen weights is used to improve the generalization and stability of the network.Then,the network model is improved according to the target detection task.The network detection speed is increased and the network parameters are decreased.Finally,the complicated scene clutter slices are used to train the network.The number of false alarm targets under background clutter is reduced.The detection results of complex multi-target scenes show that the proposed method has better detection performance.

Keywords:transfer learning; deep convolution neural network; SAR target detection; training time

DOI:10.3969/j.issn.1672-2337.2018.05.011

修回日期:2018-01-08

收稿日期:2017-12-11;

文章编号:1672-2337(2018)05-0533-06

文献标志码:A

中图分类号:TN958;TP183

作者简介:

张 椰 男,1992年12月生,湖南湘潭人,硕士研究生,主要研究方向为SAR自动目标识别。

E-mail:353014799@qq.com