0 引言

近年来,合成孔径雷达(Synthetic Aperture Radar,SAR)在军事和民用领域的应用越来越广泛,其中一个主要应用是识别机动目标,如坦克、车辆和舰船等。

相比于光学图像,SAR图像较难提取特征,传统方法已经很难满足分类精度和速度需求,而深度学习为发展一种SAR图像智能解译框架提供了可能。当前深度学习在计算机视觉领域取得了较好的成果,在一些光学图像竞赛上取得了非常大的突破[1-2]。但是,在SAR目标识别中深度学习处于起步阶段,可用于研究的SAR数据集屈指可数[3]。深度学习是由大量数据驱动完成的,而目前也存在如ImageNet,MicrosoftCOCO等大型光学图像数据集;与光学图像不同,SAR图像受相干斑噪声等成像机制的影响,目标、阴影与背景之间的过渡区域很难分离,对其进行手工标注具有很大的主观性和随机性,所以获取大量带标注的SAR图像数据需要耗费高昂的人力成本。因此,研究深度学习在少量样本下的SAR目标识别不仅能降低数据需求,还能提高识别精度。

深度学习中一般采用样本增强的方式进行数据扩充,然而传统的图像旋转、裁剪、扭曲等扩充方式不利于网络充分挖掘数据的深层信息;其次在SAR图像中,待识别目标的图像特征和相干斑噪声复杂耦合,只使用单支卷积神经网络(CNN)进行特征提取难以对目标特征和噪声进行解离。目前,迁移学习在少量样本下目标识别问题上取得了不错的成果[4],通过把大型通用数据集上预训练得到的模型迁移到其他小规模数据集上,有效解决了CNN在少量样本下训练样本不足的问题。但是迁移学习的理论基础是目标域和源域数据具有相似的底层特征,而SAR图像和光学图像在成像方式、噪声等方面仍存在较大差异,因此迁移学习在SAR数据集上的鲁棒性较差。

针对上述少量样本下SAR目标识别训练样本不足的问题,本文提出了一种创新的构建正负样本对的方式实现样本扩充,在此基础上结合度量学习和深度学习设计了一种能充分挖掘样本信息的深度度量网络——孪生卷积神经网络,最后通过多任务联合学习的方式训练模型,降低过拟合风险。

1 少量样本下的SAR目标识别方法

当训练样本较少时,SAR目标识别可以仿照人脸识别的解决方案[5-6],比较待识别样本与训练集中的每张图片,然后挑选出哪一张与它最可能是同样类别,从而将目标识别问题转化为判断两个样本是否属于同一类的二分类问题。深度学习可以提取样本的特征向量,而度量学习可以学习两个特征向量的距离度量。该距离可用来刻画样本之间的相似程度,距离越小,两个样本越相似,属于同一类的概率就越大。

1.1 数据扩充

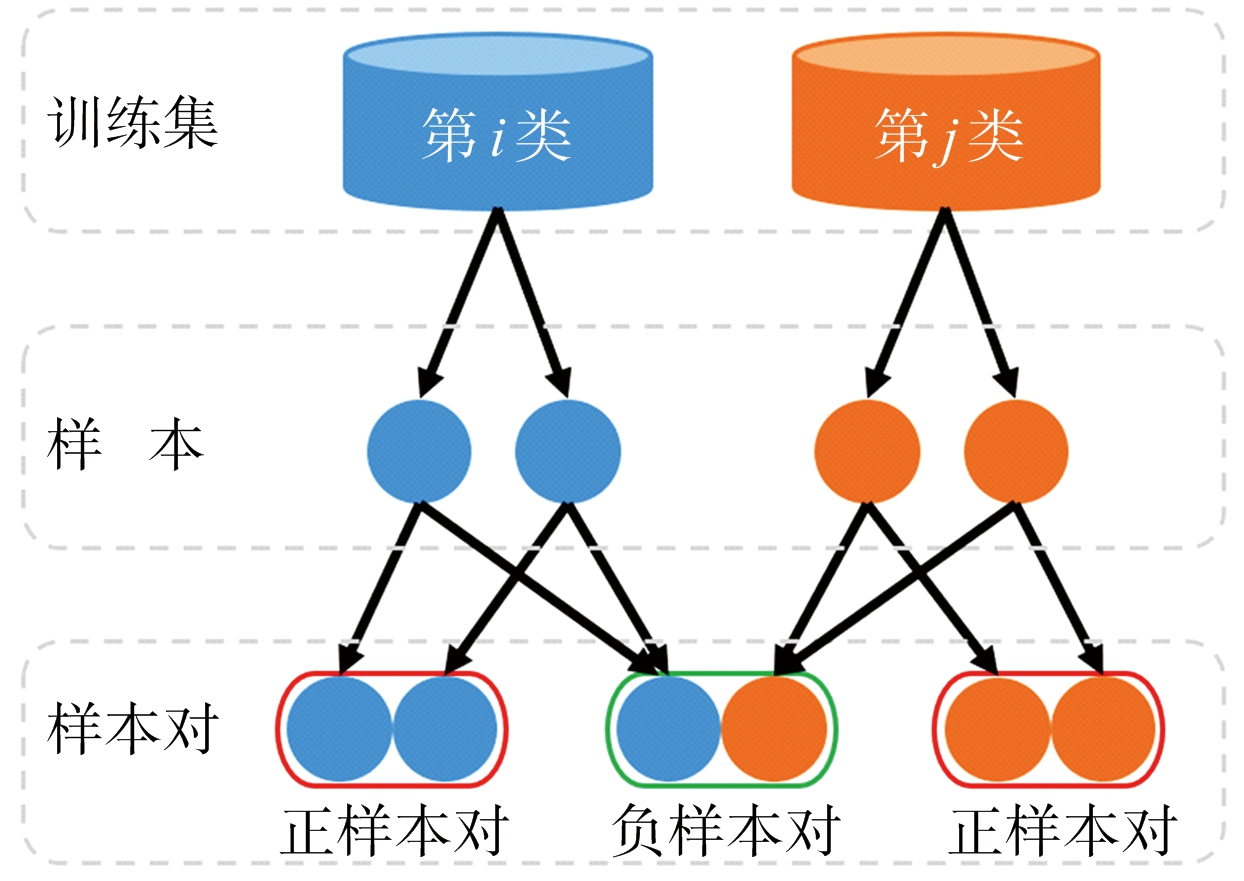

如上所述,判断两个样本是否同类时模型的输入不再是单个样本,而是两个样本构成的样本对。这里样本对分为两类:来自同一类的正样本对和来自不同类的负样本对,如图1所示。由于模型采用逐对训练,因此将会有平方级别数目的样本对来训练模型,这相当于一种变相的数据扩充,使模型很难过拟合。假设训练集有E类,每类有C个样本,总共可能的样本对数量可由式(1)计算:

Npairs=![]()

C≥2,E≥2

(1)

相比原始数据集扩充了(C·E-1)/2倍。

图1 构建正负样本对

1.2 模型

1.2.1 孪生卷积神经网络

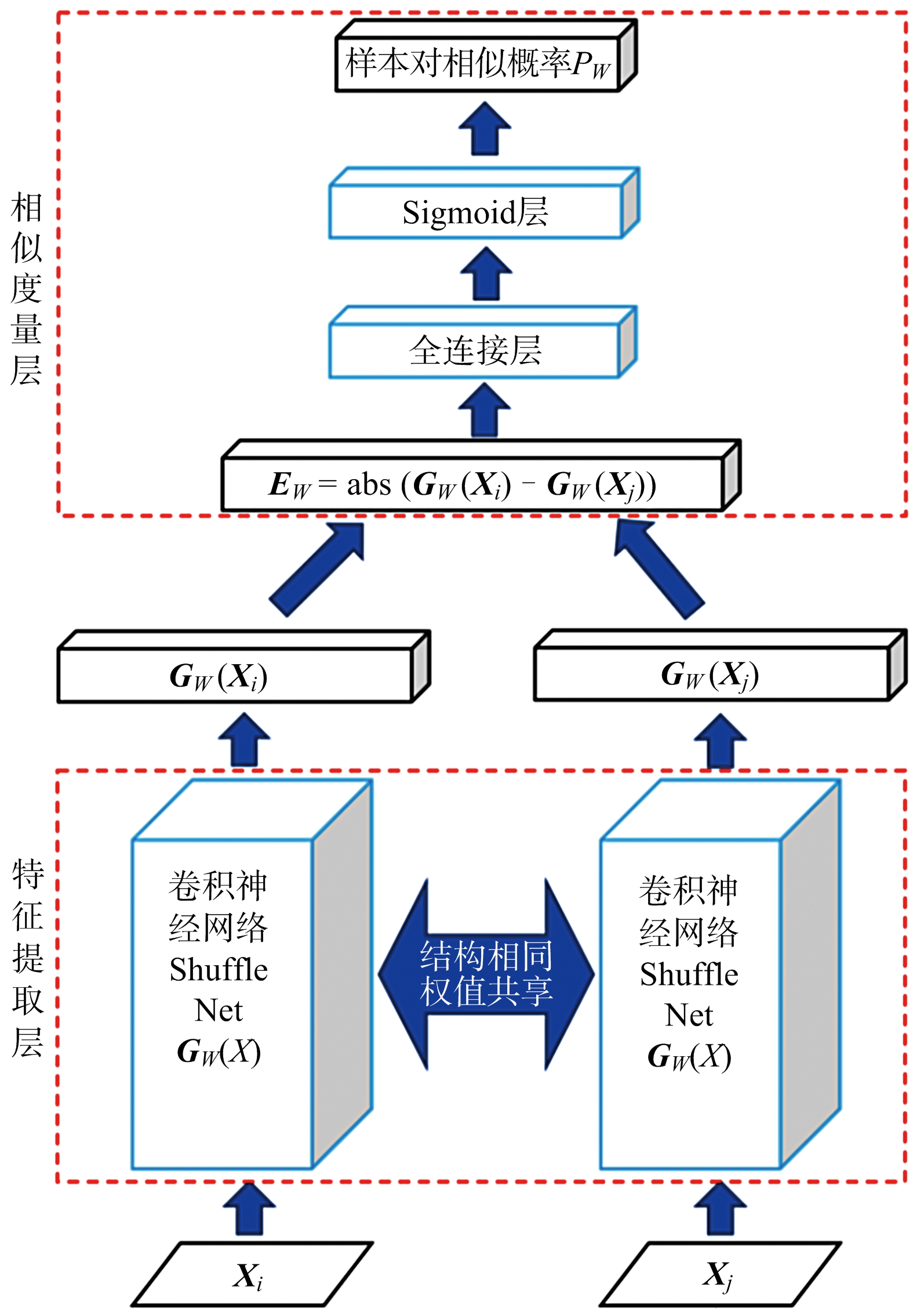

本文将两个完全相同且共享权值的CNN通过一个非参的相似度量层相连,构成可用于度量两个样本间相似度的孪生卷积神经网络,如图2所示。为了降低模型复杂度,本文采用轻量级卷积神经网络ShuffleNet作为特征提取网络。ShuffleNet[7]是旷视提出的基于组卷积和深度可分离卷积的轻量级网络,在大幅减少参数量的同时仍能保持较大的容量,非常适合少量样本下的识别任务。

图2 孪生卷积神经网络结构

首先将SAR样本对Xi=(xi,1,xi,2,…,xi,n)和Xj=(xj,1,xj,2,…,xj,n)输入模型,通过ShuffleNetGW(X)提取特征,得到特征向量GW(Xi)和GW(Xj),长度为1 000。然后计算GW(Xi)和 GW(Xj)的差值向量EW,如式(2)所示。

EW=abs(GW(Xi)-GW(Xj))=

(|xi,1-xj,1|,|xi,2-xj,2|,…,

|xi,1 000-xj,1 000|)

(2)

再将EW通过一shape=[1 000,1]的全连接层,得到GW(X1)和GW(X2)的距离度量:

dist(Xi,Xj)=

ω1·|xi,1-xj,1|+ω2·|xi,2-xj,2|+

…+ω1 000·|xi,1 000-xj,1 000|+b=

EWW+b

(3)

式中,W=(ω1,ω2,…,ω1 000)T是该全连接层的权重矩阵,b为偏差,可通过学习确定。易知,dist(Xi,Xj)=dist(Xj,Xi),满足对称性。然后经过Sigmoid层将dist(Xi,Xj)转化为一个[0,1]区间内的数值PW,即样本对属于同一类的相似概率:

PW=Sigmoid(margin-dist(Xi,Xj))

(4)

式中,margin为间隔阈值,取margin=6.0。当dist(Xi,Xj)>margin时,PW<0.5,则判定样本对不属于同一类;dist(Xi,Xj)越小,PW更接近于1,表示样本对的相似度更高。训练时,模型会倾向于使正样本对的距离不断减少;而使负样本对的距离不断增大,逐步趋近于margin。最后构造一个基于PW的交叉熵损失函数:

Lmetric=-[l*log(PW)+(1-l)*

![]()

(5)

式中:l是样本对的标签,正样本对l置为1,负样本对l置为![]() 是L2正则项函数,可以增强模型的泛化能力。

是L2正则项函数,可以增强模型的泛化能力。

1.2.2 多任务联合学习

孪生CNN可以衡量两个样本是否属于同一类,但无法分辨单个样本的具体类别。因此可以在孪生CNN上添加额外的全连接层(shape= [1 000,10])和Softmax层,构造两个基于交叉熵损失的单样本分类任务,如图3所示。

图3 多任务联合学习模型

通过这种多任务联合学习[8]的训练方式,相似度量和分类任务可以互相辅助学习,使得模型既可以分辨两个样本是否相似,也能识别单个样本的类别;另外,由于各任务有不同的噪声模式,同时学习多个任务可以对噪声进行平均,分担各自的过拟合风险,得到更为泛化的表示,有利于缓解SAR图像相干斑噪声的影响。

该模型包含了两个分类任务和一个相似度量任务,因此总损失函数由3部分组成,如式(6)所示,其中Lcls_Xi和Lcls_Xj是分类任务的交叉熵损失,λ是其损失权重。

Ltotal=λ*(Lcls_Xi+Lcls_Xj)+

(1-2λ)*Lmetric

(6)

1.3 训练

由式(1)可知,若训练集有E类,每类有C个样本,则正样本对的数量为

Npospairs=![]()

C≥2,E≥2

(7)

因此正负样本对的比例为

(8)

可见当类别较多时,负样本对要远多于正样本对,因此在训练时需对负样本对作难区分负样本挖掘[9-10](hard negative mining),这样有利于避免振荡,加快网络收敛。基于前文定义的样本距离度量dist(Xi,Xj),设定一区间[A, B],可将负样本对分为以下3类:

a) 易区分负样本对:dist(Xi,Xj)>B,此类负样本对相似度较低,因此较容易识别;

b) 模糊负样本对:A≤dist(Xi,Xj)≤B,处在模糊区域的负样本对;

c) 难区分负样本对:dist(Xi,Xj)<A,此类负样本对距离很近、相似度非常高,属于难以准确识别的样本对。

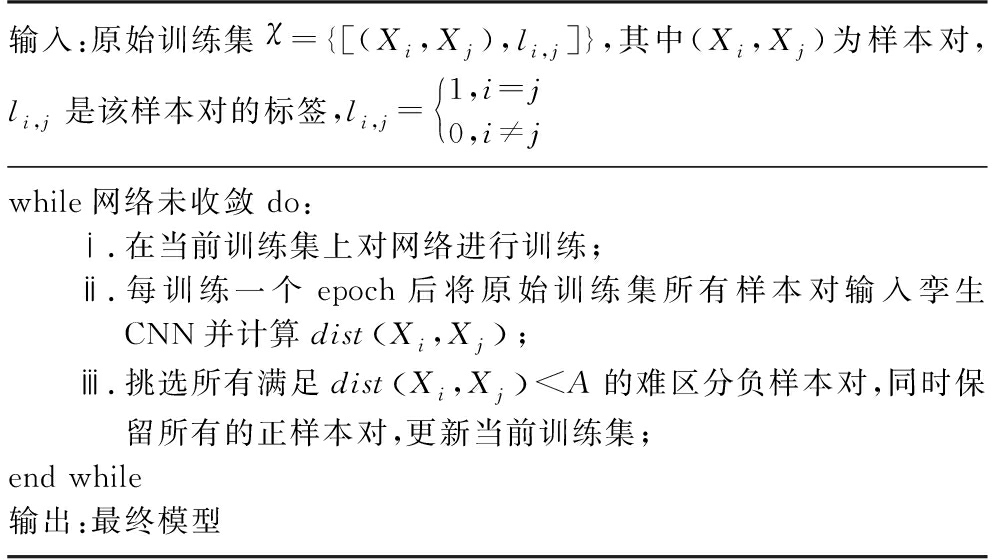

显然,难区分负样本对在训练中容易造成混淆,因此应着重关注这一类负样本对,该类样本对的选取算法如表1所示。

表1 难区分负样本对挖掘算法

输入:原始训练集χ={[(Xi,Xj),li,j]},其中(Xi,Xj)为样本对,li,j是该样本对的标签,li,j=1,i=j0,i≠j while网络未收敛 do:ⅰ.在当前训练集上对网络进行训练;ⅱ.每训练一个epoch后将原始训练集所有样本对输入孪生CNN并计算distXi,Xj ;ⅲ.挑选所有满足distXi,Xj

训练时的每个批量处理(batch)包含了多个正负样本对,若按式(8)中的比例安排批量处理,在大量负样本对的影响下网络训练几乎无法收敛,因此本文将每个批量处理中的正负样本对比例确定为1∶1来均衡正负样本对对损失函数的影响,使模型可以稳定收敛。

1.4 类别推断

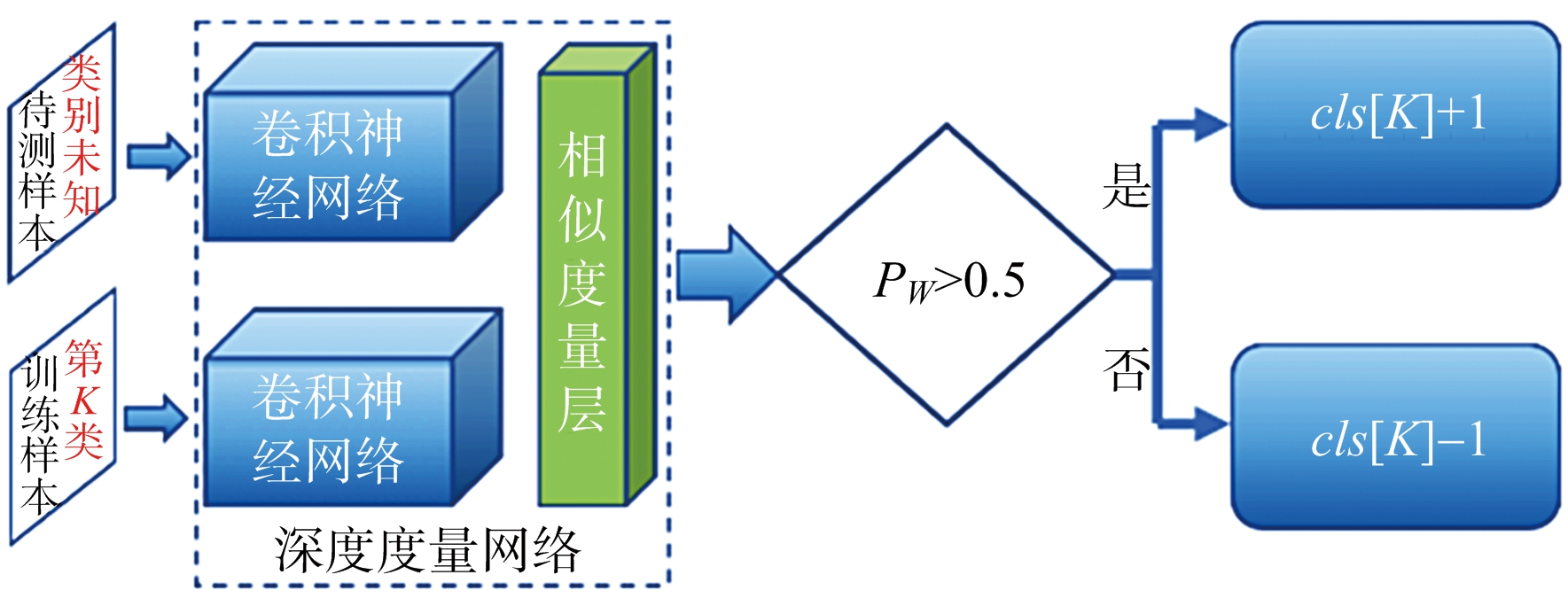

在预测阶段,本文设计了一种基于孪生CNN和加权投票的识别算法来推断待测样本的类别,如图4所示。假设训练集共包含N类样本,维护一个结果数组cls[N]储存推断时训练集所有样本的投票结果。

图4 待测样本的识别流程

具体推断算法如表2所示,虽然需要同所有训练样本进行比较,但在小规模训练集上比较次数较少,因此可以达到实时性识别的要求。

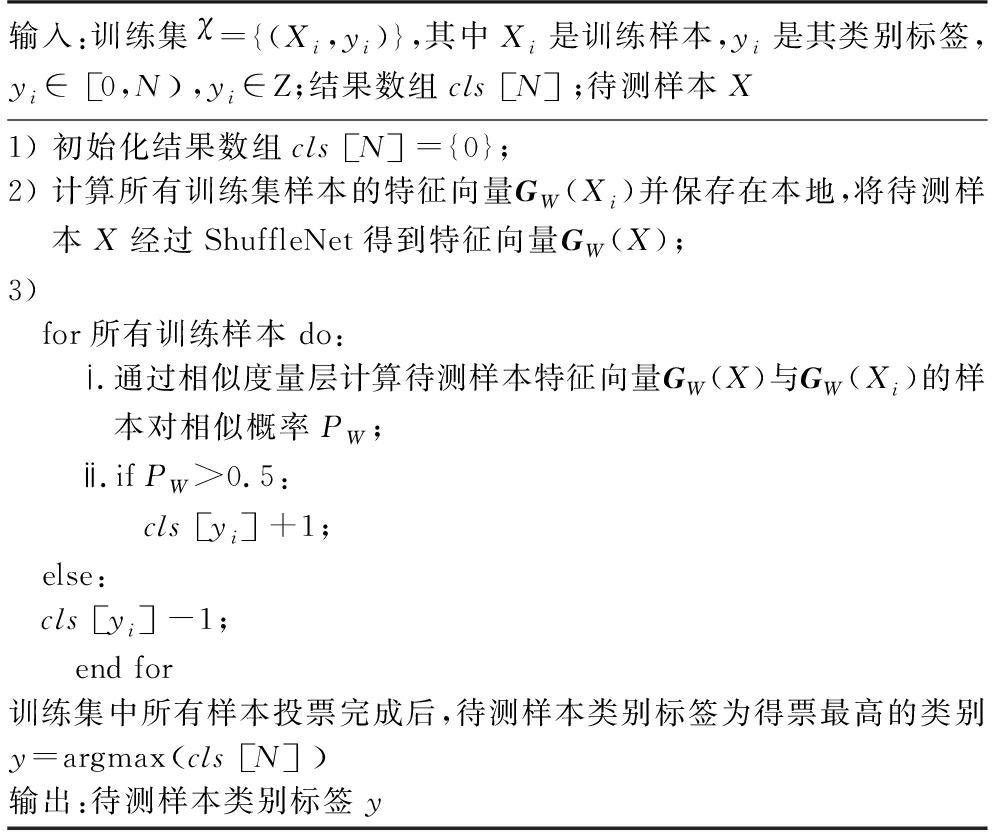

表2 待测样本识别算法

输入:训练集χ={(Xi,yi)},其中Xi是训练样本,yi是其类别标签,yi∈0,N ,yi∈Z;结果数组clsN ;待测样本X1) 初始化结果数组clsN ={0};2) 计算所有训练集样本的特征向量GW(Xi)并保存在本地,将待测样本X经过ShuffleNet得到特征向量GW(X);3)for所有训练样本 do: ⅰ.通过相似度量层计算待测样本特征向量GW(X)与GW(Xi)的样本对相似概率PW; ⅱ.ifPW>0.5:clsyi +1;else:clsyi -1; end for训练集中所有样本投票完成后,待测样本类别标签为得票最高的类别y=argmaxclsN 输出:待测样本类别标签y

2 实验结果与分析

2.1 数据集及实验设置

2.1.1 MSTAR

目前国内外对SAR图像进行的研究大多使用该数据集,其中包含大量地面目标切片。取17°俯仰角样本作为训练集,15°俯仰角样本为测试集。为减少计算量,截取图像中心包含目标的64 ×64大小的目标切片进行试验。MSTAR中共计10类目标,各类样本数量较均衡,在195~274之间。

2.1.2 OpenSARShip

OpenSARShip[11]是2017年上海交大提出的第一个舰船SAR图像数据集。由于部分类别所含样本极少,所以本文只取其中货船下的5个子类进行实验,每类样本数如表3所示。同MSTAR的处理方法一样,截取图像中心包含目标的64 ×64大小的图像切片。

表3 OpenSARShip 5类样本各自样本数

类别货船集装船散装船杂货船其他样本数367015822298526394

2.1.3 数据预处理

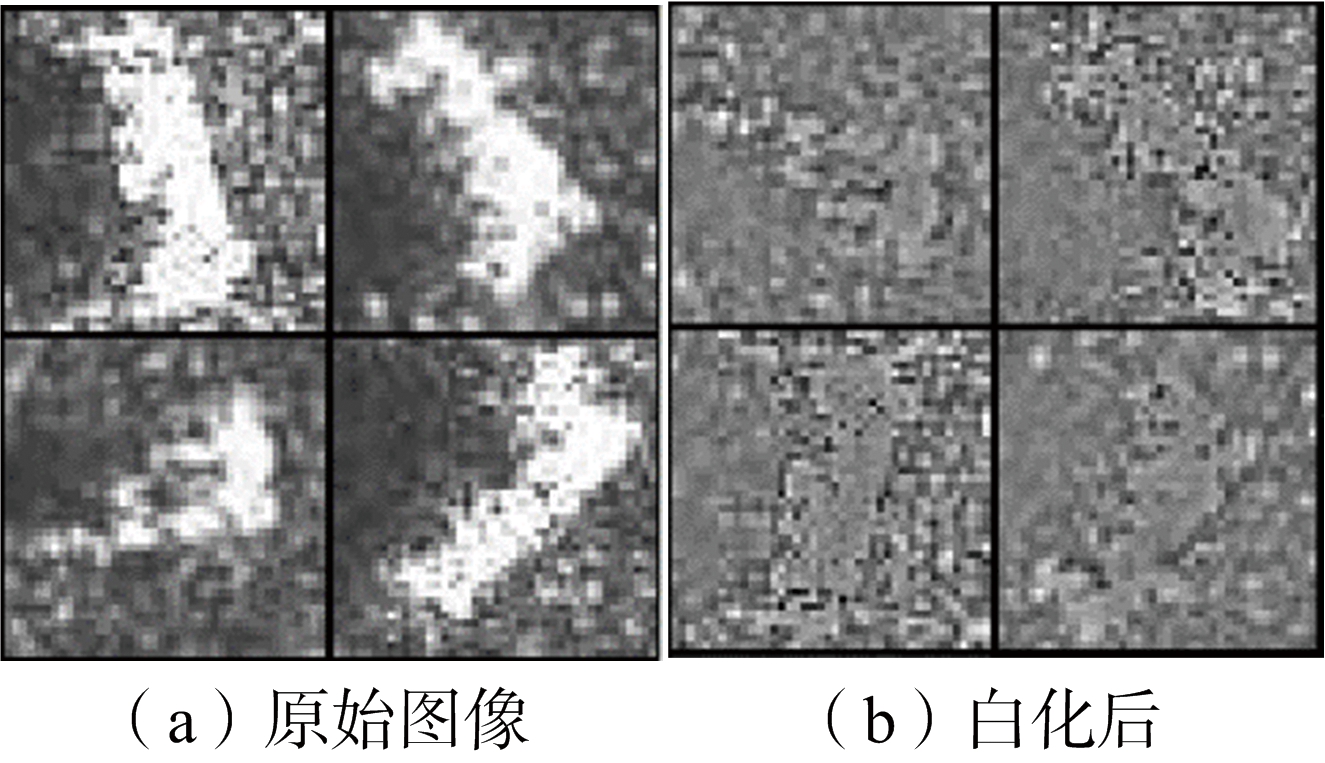

由于SAR图像相邻像素之间具有很强的相关性,所以用原始图像进行训练时会存在冗余现象,而白化处理后的图像会降低特征之间的相关性,并使所有的特征具有相同的方差,如图5所示。

图5 SAR图像白化

白化处理后再对原始数据集做人工提高训练样本数量,这是提高机器学习算法性能的一种常用技巧。由于SAR目标的环拍角度对其图像特征影响较大,所以在样本增强时不应采用翻转、镜

像等方式。本实验对原始训练集中所有样本,以图像中心点为旋转点,分别进行顺时针±10°的旋转,将样本量增强为原有规模的3倍。

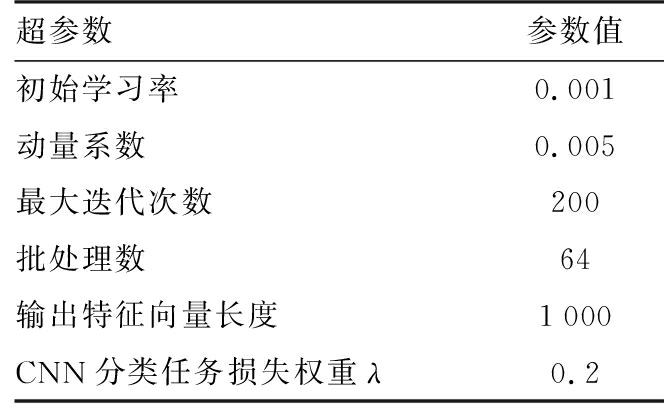

2.1.4 模型超参数设置

本文模型训练的基本超参数设置如表4所示。硬件配置为CPU:Inteli7-8700 K @ 3.60 GHz,32 G内存,GPU:GTX 1080Ti @11 GB显存;软件环境是Windows10,深度学习框架TensorFlow 1.10,Python 3.6,CUDA 9.0, cuDNN 7.4。

表4 模型超参数

超参数参数值初始学习率0.001动量系数0.005最大迭代次数200批处理数64输出特征向量长度1000CNN分类任务损失权重λ0.2

2.2 算法对比实验

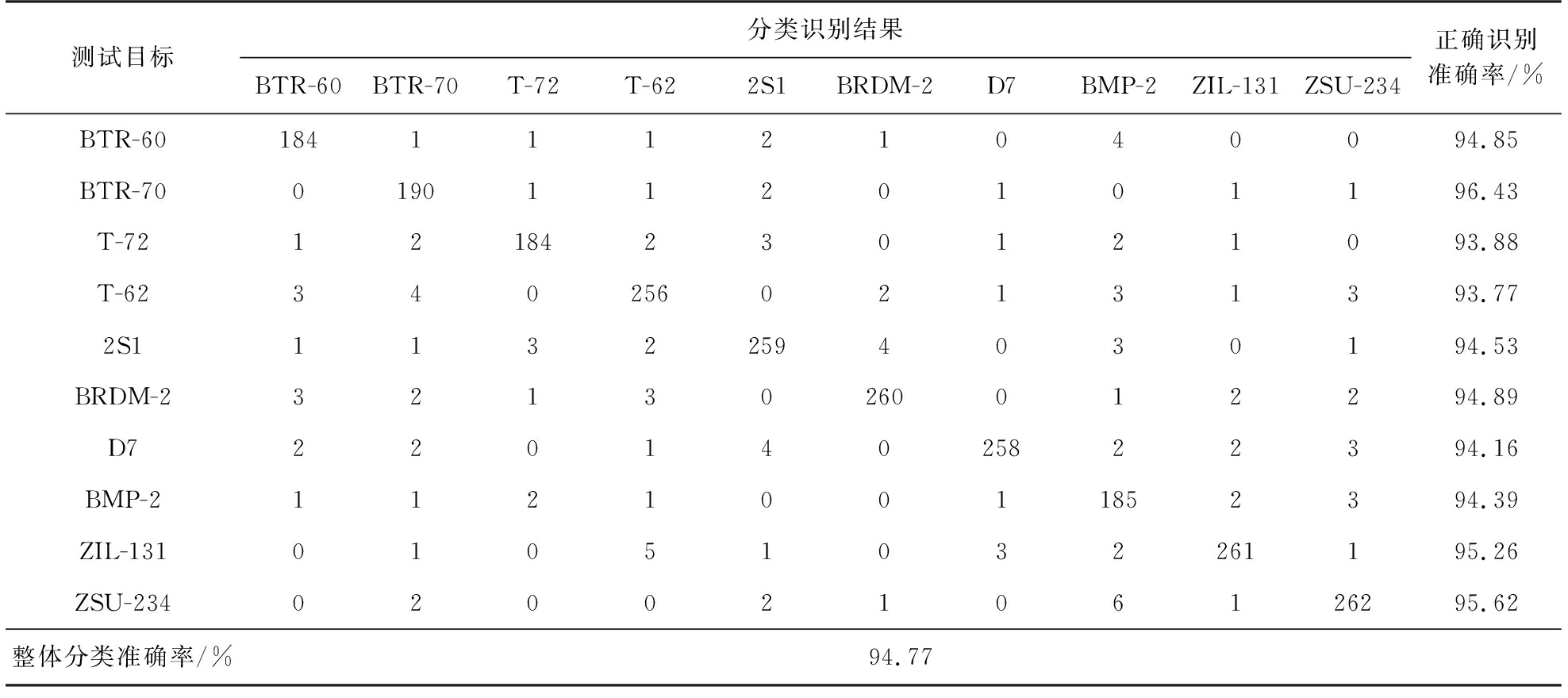

2.2.1 分类识别结果

为营造少量样本环境,对MSTAR训练集中共10类目标均以环拍角度等间隔欠采样,使得每类样本数据量约为原数据量的1/10。以欠采样后的新数据集作为训练集,按照表4的超参数训练模型,在完整MSTAR测试集上的分类识别结果如表5所示。可以看出,本文方法在使用少量样本训练后,模型识别结果较好,并未出现过拟合。

表5 MSTAR 10类目标混淆矩阵

测试目标分类识别结果BTR-60BTR-70T-72T-622S1BRDM-2D7BMP-2ZIL-131ZSU-234正确识别准确率/%BTR-6018411121040094.85BTR-7001901120101196.43T-7212184230121093.88T-6234025602131393.772S111322594030194.53BRDM-232130260012294.89D722014025822394.16BMP-211210011852394.39ZIL-13101051032261195.26ZSU-23402002106126295.62整体分类准确率/%94.77

2.2.2 几种识别算法的对比

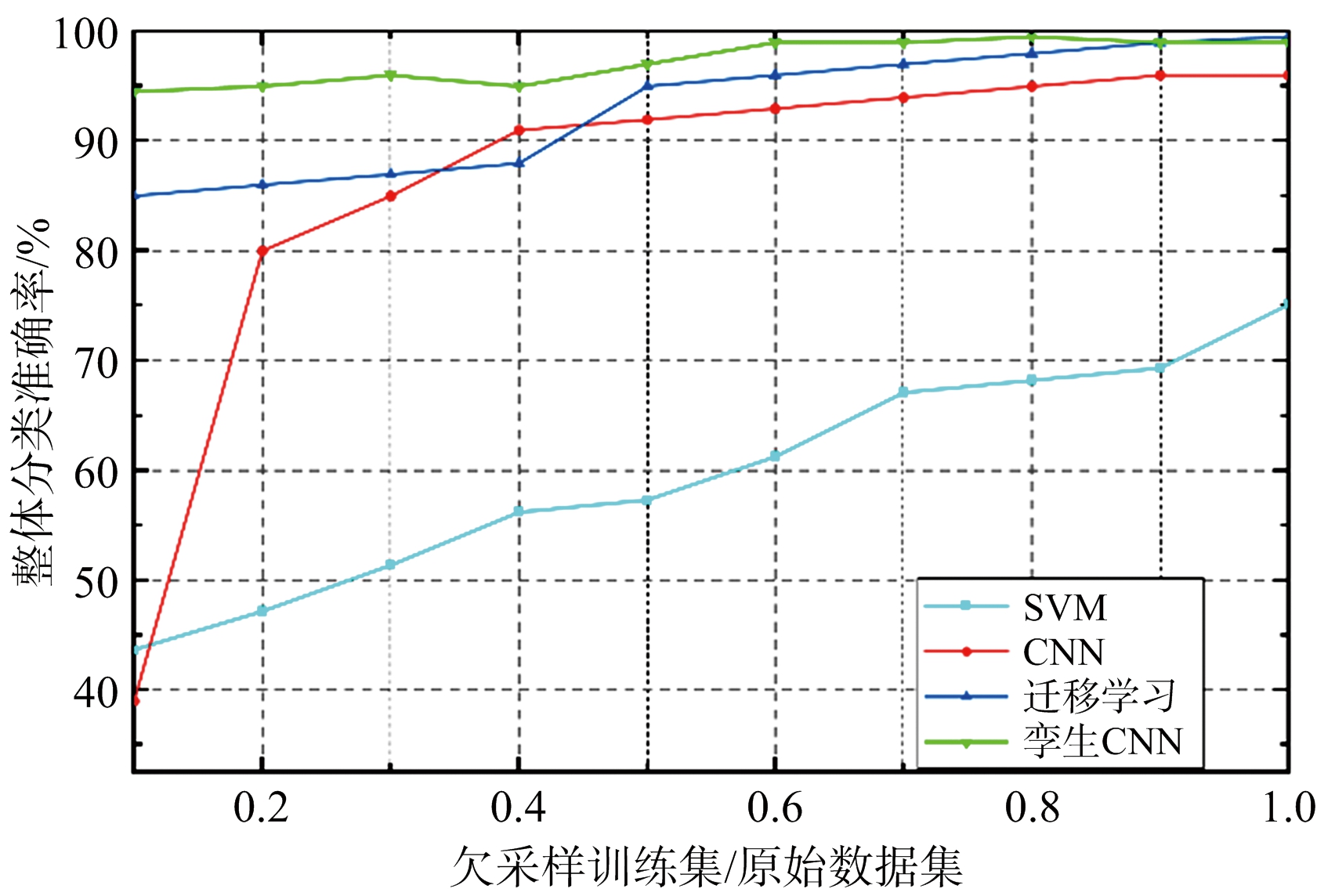

机器学习中支持向量机(SVM)在少量样本下性能较好;深度学习中传统识别算法使用CNN接Softmax层进行分类;迁移学习使用大规模通用数据集上训练好的模型在小规模SAR样本集上进行微调。为测试本文方法与同类算法的差异,本文在相同条件下在MSTAR上进行了若干对比实验。

首先对MSTAR训练集中共10类目标均以环拍角度间隔欠采样,分别按占原数据量1/10, 2/10,…,1的比例构造10个新训练集,每种情况均使用完整测试集进行评估,得到各算法的10类整体分类准确率随训练集规模的变化情况如图6所示。可以看出,在少量训练样本下,孪生CNN分类效果最优,而CNN和SVM此时均出现了过拟合现象,泛化性能较差;随着训练样本量逐渐增多,孪生CNN始终能维持在较高的水平。同等样本量下,孪生CNN分类性能优于其他方法。

图6 几种分类算法的结果对比

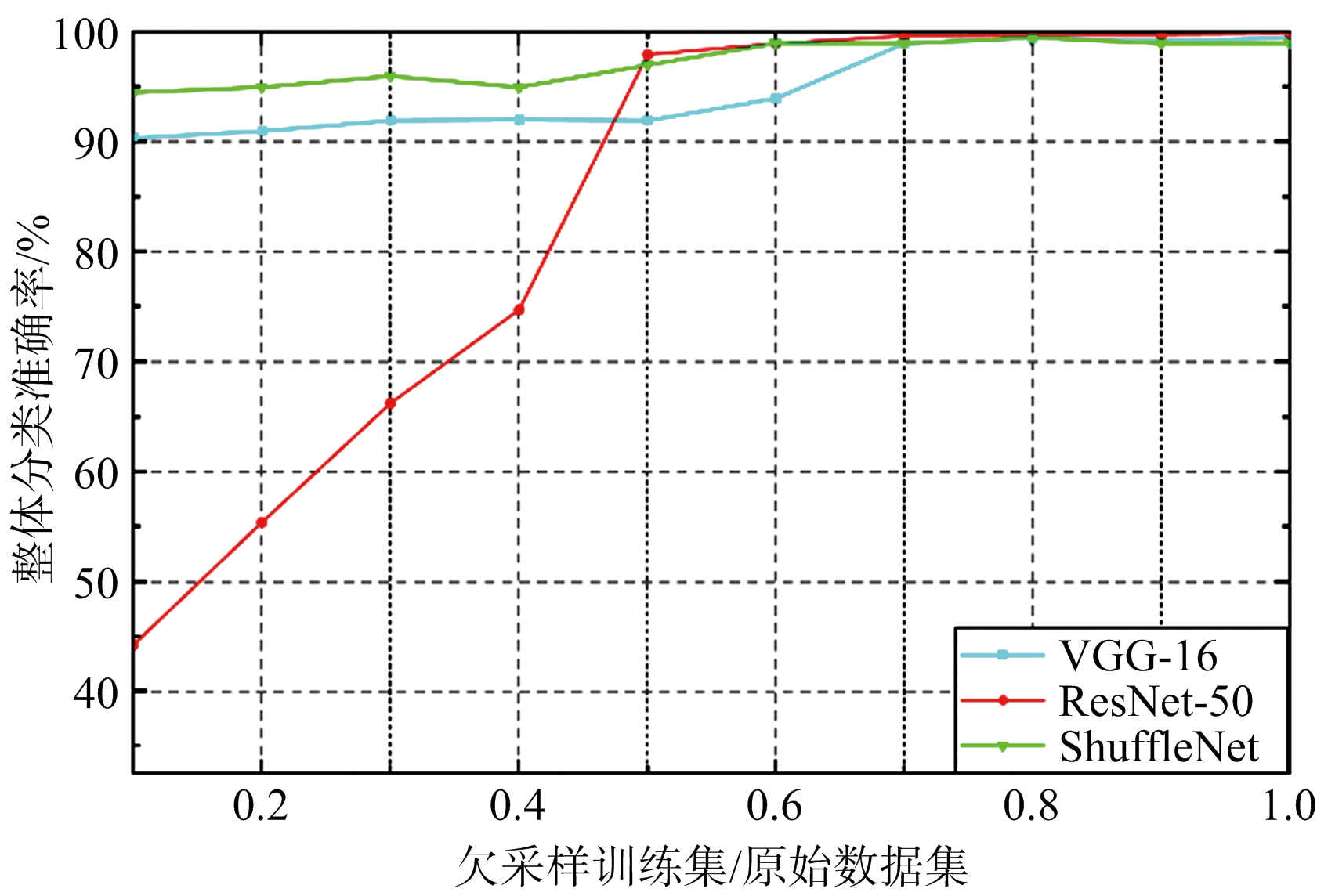

2.2.3 几种特征提取网络的对比

为了探究特征提取层使用不同CNN对结果的影响,本文将ShuffleNet分别更换为VGG-16 Net和ResNet-50,在2.2.2节的实验条件下做了相关对比实验,结果如图7所示。可以看出,在少量样本下ShuffleNet表现更好,而在训练集规模较大时,更复杂的VGG-16和ResNet-50性能较好,这是由于在少量样本下使用复杂度较低的模型可以降低过拟合风险。

图7 几种卷积网络的结果对比

2.3 算法有效性及泛化分析

2.3.1 可视化分析

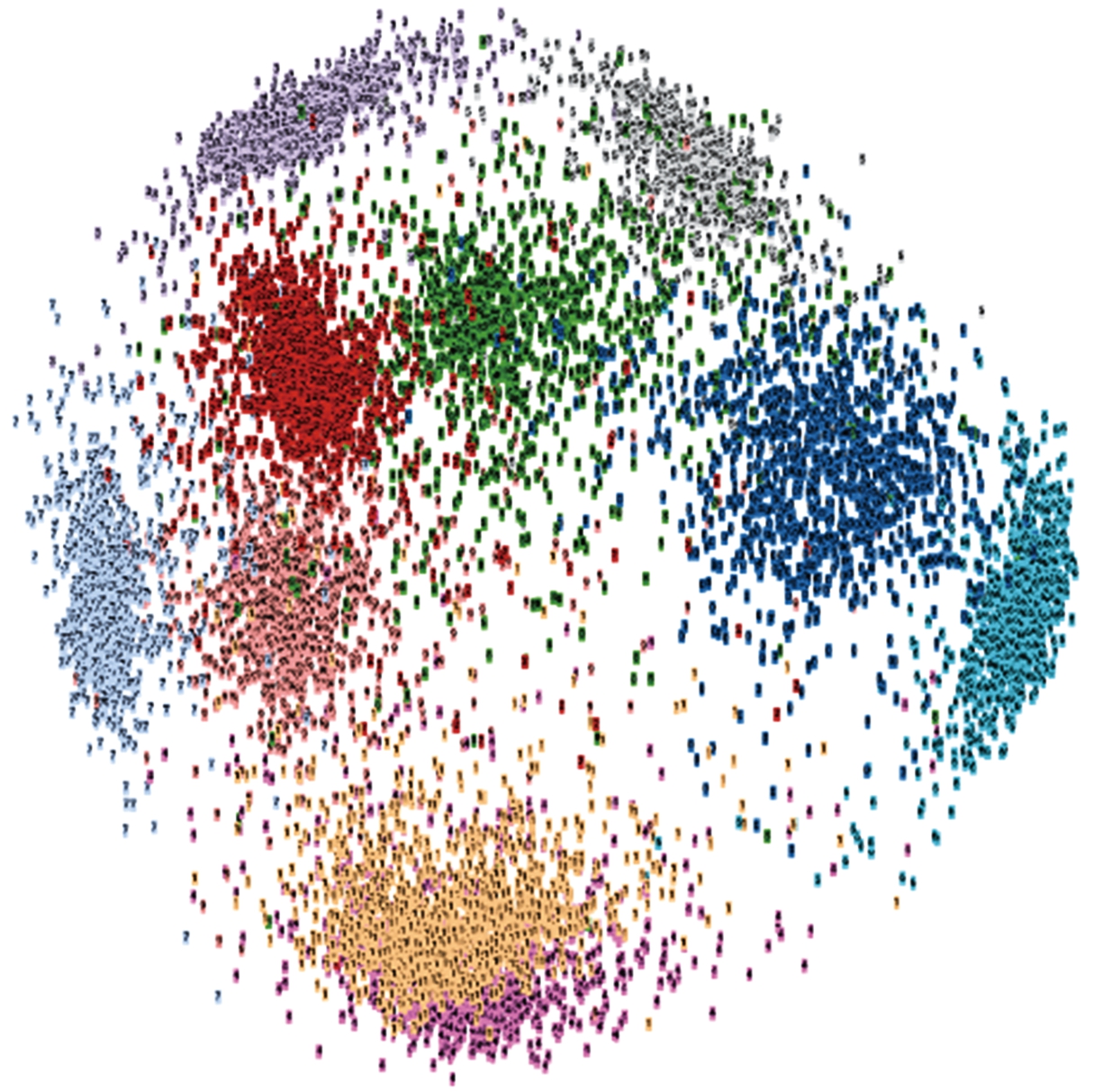

t-SNE[12]是一种将高维数据映射到低维空间的降维算法。为了更直观地体现基于深度度量学习的孪生CNN方法对样本分布的影响,本文使用t-SNE降维可视化方法将MSTAR完整测试集通过ShuffleNet输出的特征向量GW(X)映射在二维平面上观察样本分布情况,如图8所示。可见随着不断迭代训练,类内样本对的距离不断缩小,类间样本对的距离不断加大,直到各类别间形成一定间隔。因此,深度度量学习通过优化样本间距来调整各类样本分布,主要体现在减小类内距离、增大类间距离,最终使样本分布形成聚类效应。这是孪生CNN实现SAR目标识别的主要原因之一。

(a) 训练1个迭代周期后

(b) 训练10个迭代周期后

图8 MSTAR测试集t-SNE降维可视化结果

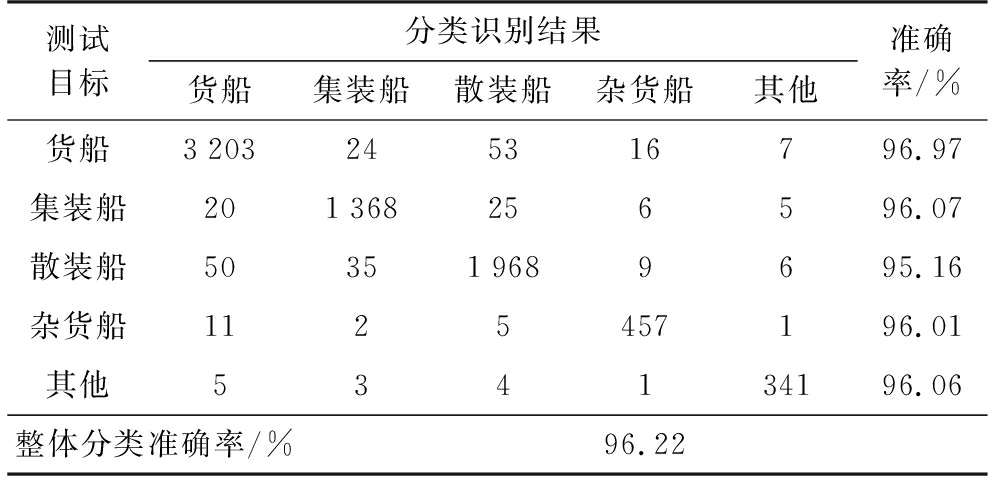

2.3.2 泛化分析

为了测试本文方法在其他SAR数据集上的识别效果,本文在OpenSARShip上进行了和2.2.1节相同条件下的实验。欠采样1/10数据作为训练集,其余样本作为测试集,识别结果如表6所示。可见本文方法在OpenSARShip上也取得了较好的分类性能,初步验证了孪生CNN识别方法的泛化能力。

表6 OpenSARShip 5类目标混淆矩阵

测试目标分类识别结果货船集装船散装船杂货船其他准确率/%货船3203245316796.97集装船201368256596.07散装船503519689695.16杂货船1125457196.01其他534134196.06整体分类准确率/%96.22

3 结束语

从本文的结果可见,基于孪生CNN的SAR目标识别方法在少量样本下表现出了较理想的性能,但本文的例子所适用的范围有限,真正应用到实际业务中还需要进行更深入更广泛的研究。比如雷达俯仰角和环拍角度对SAR图像特征影响较大,如何均匀采集训练样本是亟需研究的课题。针对SAR图像这样电磁波散射物理过程的产物,需要融合电磁散射和深度学习等理论,将物理规律等先验知识体现在解译算法中,才能发展出一套成熟的SAR智能解译框架。

[1] HU Jie,SHEN Li,SUN Gang,et al. Squeeze-and-Excitation Networks[C]∥ 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition,[S.l.]: IEEE,2017:7132-7141.

[2] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep Residual Learning for Image Recognition[C]∥ 2016 IEEE Conference on Computer Vision & Pattern Recognition, Las Vegas, NV :IEEE,2016:770-778.

[3] XU Feng, WANG Haipeng, JIN Yaqiu. Deep Learning as Applied in SAR Target Recognition and Terrain Classification[J]. Journal of Radars, 2017(2): 1-13.

[4] 张椰,朱卫纲.基于迁移学习的SAR图像目标检测[J].雷达科学与技术,2018,16(5):533-538.

ZHANG Ye, ZHU Weigang. Target Detection in SAR Images Based on Transfer Learning[J]. Radar Science and Technology , 2018,16(5):533-538.(in Chinese)

[5] SUN Yi, WANG Xiaogang, TANG Xiaoou. Deeply Learned Face Representations are Sparse, Selective, and Robust[C]∥ 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),Boston, MA:IEEE, 2015:1-25.

[6] CHU Weita, LI Weiwei. Manga FaceNet: Face Detection in Manga Based on Deep Neural Network[C]∥ Proceedings of the 2017 Acm on International Conference on Multimedia Retrieval,New York :IEEE,2017:412-415.

[7] ZHANG Xiangyu, ZHOU Xinyu, LIN Mengxiao, et al. ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile Devices[C]∥ 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition,[S.l.]:IEEE,2017:6848-6856.

[8] LEE G, YANG E, HWANG S J. Asymmetric Multi-Task Learning Based on Task Relatedness and Loss[C]∥ International Conference on Machine Learning,New York :IEEE,2016:230-238.

[9] HERMANS A , BEYER L , LEIBE B . In Defense of the Triplet Loss for Person Re-Identification [C]∥ 2017 IEEE International Conference on Computer Vision,[S.l.]:IEEE,2017:5426-5434.

[10] BUCHER M, HERBIN S, JURIE F. Hard Negative Mining for Metric Learning Based Zero-Shot Classification[C]∥ European Conference on Computer Vision,[S.l.]:Springer, 2016:524-531.

[11] HUANG Lanqing, LIU Bin, LI Boying, et al. Open SAR Ship: A Dataset Dedicated to Sentinel-1 Ship Interpretation[J]. IEEE Journal of Selected Topics in Applied Earth Observations & Remote Sensing, 2018, 11(1):195-208.

[12] PAN Mian, JIANG Jie, KONG Qingpeng, et al. Radar HRRP Target Recognition Based on t-SNE Segmentation and Discriminant Deep Belief Network[J]. IEEE Geoscience & Remote Sensing Letters, 2017, 14(9):1609-1613.