0 引 言

伴随着时代进步和人类发展,汽车已成为现代人类社会中最重要的交通工具之一,给人类的生活带来了极大的便利性。然而,交通安全问题始终伴随着汽车产业的发展,每年发生的交通事故导致了人类生命和财产的巨大损失[1-2]。高级驾驶辅助系统(Advanced Driver Assistance System,ADAS)可以提高驾驶的安全性,人们对ADAS 的需求不断增加,对传感器的要求也逐渐提高[3]。

用于ADAS 的主流传感器主要包括光学传感器、超声波传感器、激光雷达和毫米波雷达等[4-5],较其他传感器,毫米波雷达具有全天时全天候的工作特点,成为了ADAS 的核心传感器。行人、骑行者和汽车是城市和乡村道路上的主要交通参与者,也是ADAS 系统的重要识别分类目标,对他们进行准确的分类识别可以有效减少交通事故的发生。由于不同的目标具有不同的运动方式,如行人在移动时四肢具有不同的摆动幅度和位置,与运动中的车辆相比具有不同的微动特征,因此微动特征已在许多研究中被用于雷达目标特征的提取及分类[6-9]。此外,文献[10]采用高分辨雷达实测数据,对两类目标的多普勒和微多普勒特征进行提取,利用目标的散射强度、速度及步态频率三类特征实现了车辆与人的分类识别,上述工作通过目标散射强度特征以及多普勒和微多普勒特征实现了行人与车辆的分类,取得了良好的效果,但道路上的主要交通参与者除了行人与车辆还包括了骑行者等,因此,实现多种目标分类至关重要。

近年来,卷积神经网络(Convolutional Neural Network, CNN)在图像处理领域取得了巨大成功,其强大的图像特征提取能力为雷达目标分类提供了新思路。例如,文献[11]对原始雷达回波信号进行处理,得到目标的距离-角度(Range-Angle,RA)图,将CNN 应用于雷达RA 图的分类,但该方法分类准确率较低,在分类结果只有行人和其他的情况下最高分类准确率只有87.9%。通过在水平方向机械旋转雷达获得RA 图,利用Darknet53网络对RA 图进行分类,可以实现汽车、行人、石头三类目标的分类[12],但是机械旋转雷达的方案并不适用于大部分车载场景。由于毫米波雷达不仅可探测到目标的整体运动,还可以探测到物体的多普勒特征和微多普勒特征,如运动中行人的四肢摆动特征和行进中车轮的运动特征等,雷达距离多普勒(Range-Doppler,RD)图像包含了目标的运动特征。所以,通过雷达RD 图像对目标进行分类是更好的选择。已有研究使用CNN 替换了传统的毫米波雷达目标分类算法,实现了对目标的单帧RD 图像进行分类[13],但在数据预处理方面存在不足,没有消除静止物体对目标多普勒或微多普勒特征产生的影响。文献[14]使用AWR1243-BOOST 雷达板采集目标回波数据,并将数据处理成多帧连续的RD 图像,使用神经网络对目标的多帧RD 图像分类,实现了汽车、行人和骑行者等目标的分类。文献[15]在文献[14]的基础上使用DCNN 和AlexNet+DRNN 等网络对目标单帧和多帧连续的RD 图像进行分类,得出了使用AlexNet+DRNN 的网络结构对多帧RD 图像进行分类的结论。但获取目标多帧RD 图像需要较长的观测时间,并且对多帧RD 图像分类需要较大的数据运算量,图像分类网络模型的空间复杂度和计算复杂度较高,存储模型参数文件需要占用较大的内存空间,运行模型时需要占用大量内存资源。因此,如何提高网络分类准确率并且使网络拥有较少的参数量和计算复杂度,是亟待解决的问题。

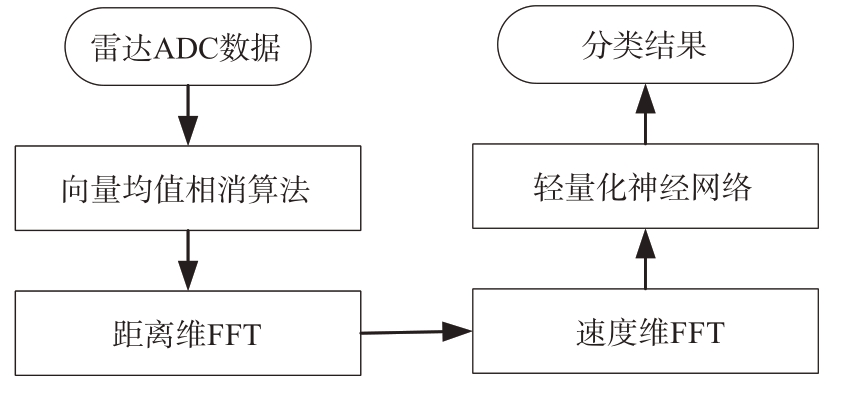

针对上述问题,本文将向量均值相消算法引入到信号处理流程中,提出了一条完整的车载毫米波雷达目标分类信号处理链,并且将MobileNet[16]和Ghost 模块[17]相结合,针对车载毫米波雷达目标分类任务设计了神经网络G-MobileNet。首先使用AWR1843BOOST 雷达板采集目标回波信号,对雷达接收信号AD 采样数据进行向量均值相消处理滤除静止杂波,然后再对数据分别进行距离维度和速度维度的快速傅里叶变换(Fast Fourier Transform, FFT)得到RD 图,最后通过G-MobileNet 对RD 图进行特征的提取以及分类。实测数据验证结果表明,本文方法具有很好的分类性能,并且所设计的网络模型复杂度较低,具有较好的工程应用前景。

1 车载毫米波雷达信号模型

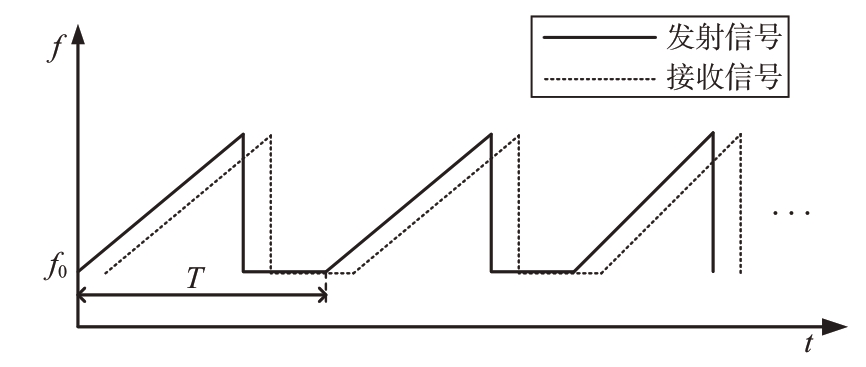

目前先进的汽车雷达传感器采用调频连续波(Frequency Modulated Continuous Wave, FMCW)技术[5]。FMCW 信号调制原理图如图1 所示,其发射信号数学模型可表示为

图1 FMCW信号调制原理图

式中:x(t)表示信号波形;k ∈[0,N-1],N 为在一个测量周期内发射信号的个数;T为发射信号重复周期,包含发射周期和空闲周期。发射信号ST(t)是在慢时间域ts=kT 上周期重复的函数。φ(t)表示发射信号的相位,可表示为

式中f0,α 和φ0 分别为FMCW 信号的起始频率、调斜率和初始相位。

定义快时间tf:

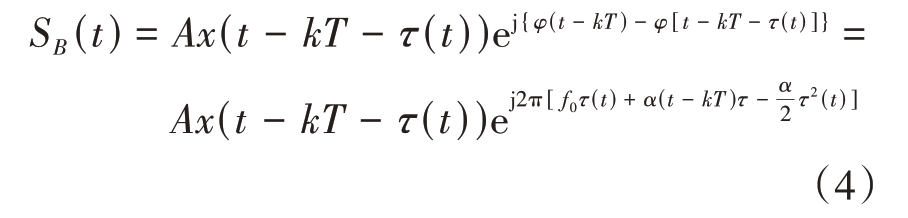

发射信号ST(t)经过目标反射后被雷达接收机所接收,并进行混频和低通滤波处理,产生的基带信号可表示为

式中,A 表示目标回波信号幅值,τ(t)是信号发射之后经过目标反射并被接收的双程时延,表达式为

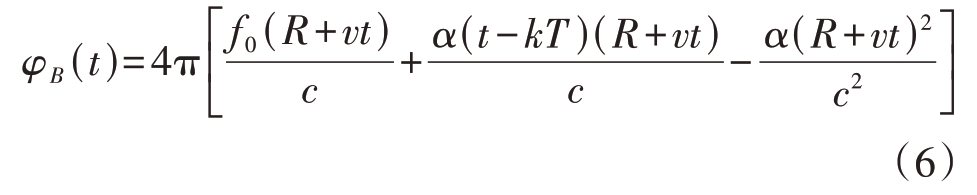

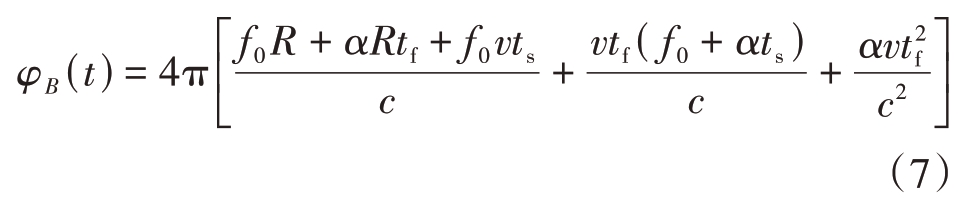

式中,R为目标与雷达之间的距离,v为目标的径向速度,c 为光速。联立式(4)和式(5),可得接收信号SB(t)的相位:

由于c2 ≫2α(R + vt)2,所以公式(6)的第三项可忽略不计。联立式(6)和式(3)可得

由于![]() 所以公式(7)的第三项可忽略不计,接收信号可表示为

所以公式(7)的第三项可忽略不计,接收信号可表示为

公式(8)第一项指数因子中,![]() 表示恒定频率分量,

表示恒定频率分量,![]() 为对应于距离的快时频率分量,

为对应于距离的快时频率分量,![]() 是对应于相对径向速度的慢时频率分量,第二项指数因子对应于距离偏移和多普勒频移效应,在当前的汽车雷达系统中通常忽略距离偏移和多普勒频移效应[5]。

是对应于相对径向速度的慢时频率分量,第二项指数因子对应于距离偏移和多普勒频移效应,在当前的汽车雷达系统中通常忽略距离偏移和多普勒频移效应[5]。

2 基于Ghost模块的车载雷达目标分类方法

由公式(8)可知,雷达接收信号包含了一个对应于距离的快时频率和一个对应于相对径向速度的慢时频率,所以分别在快时间域和慢时间域对目标回波信号做FFT 可以得到目标的雷达RD 图像,不同目标具有不同的形状和多普勒特性,所以具有不同的雷达RD 图像,可通过雷达RD 图像特征实现对目标的分类。

本文提出的目标分类流程如图2所示,由于原始雷达回波信号中会存在静止杂波,当目标速度较慢的时候静止杂波会对目标造成干扰,甚至会湮没目标的微动多普勒特征,所以采用向量均值相消算法滤除静止杂波,同时保留目标的微动多普勒特征。即首先对雷达目标回波进行向量均值相消滤波,然后再对滤波之后的信号分别进行距离维度FFT 和速度维度FFT 得到雷达RD 图像,最后使用轻量化神经网络提取雷达RD 图像特征并得到分类结果。

图2 目标分类流程图

2.1 基于向量均值相消算法的静态杂波滤除

将雷达接收信号AD 采样数据表示为矩阵R ∈ℂM×N,其中M 为快时间维度采样点数,即每个FMCW 信号的采样点数,N表示慢时间维度采样点数,即每个观测周期内FMCW 信号的个数,对所有FMCW信号求平均值:

式中,q ∈ℂM×1 是对所有FMCW 信号求平均得到的参考信号,均值相消的过程可表示为

这里,Q=[q,q,…,q]∈ℂM×N,P ∈ℂM×N 为向量均值相消后得到的信号。

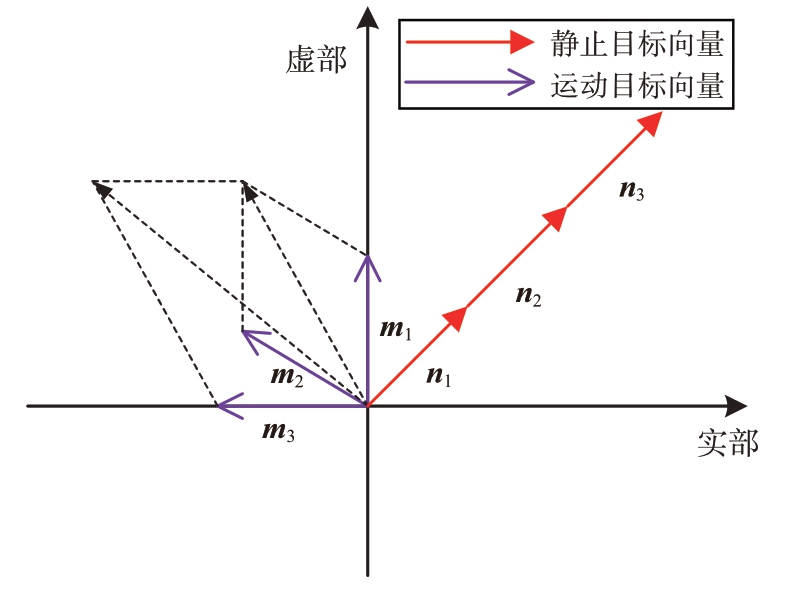

图3 为当N=3 时目标回波向量求和示意图,m1,m2,m3 为运动目标的向量,由于目标运动会导致回波信号中每个调频信号间的相位不同,其相量求和累加后会出现抵消的现象,n1,n2,n3为静止目标的向量,静止目标回波中每个调频信号间的相位相同,相量求和累加后得到的值较大。因此,参考信号q中运动目标回波信号分量较小,静止目标回波信号分量较大且与每个接收信号中静止分量相同,使接收信号R 中的每一个FMCW 信号都消去参考信号,可消除静止目标回波信号分量,同时保留了运动目标回波信号分量。

图3 相量求和示意图

2.2 G-MobileNet轻量化网络设计

神经网络中普通卷积层运算的数学模型可表示为

式中,*代表卷积算子,X ∈ℝl×h×w代表输入数据,其中l,h和w分别为输入通道数、输入数据的长和宽;F ∈ℝl×g×g×n 指大小为g × g 的卷积核;B ∈ℝh'×w'×n为偏置项;Y ∈ℝh'×w'×n 为输出数据;h',w'和n 分别为输出数据的长、宽和输出通道数。经过一次卷积过程的浮点运算数量可以表示为n·h'·w'·l·g·g。

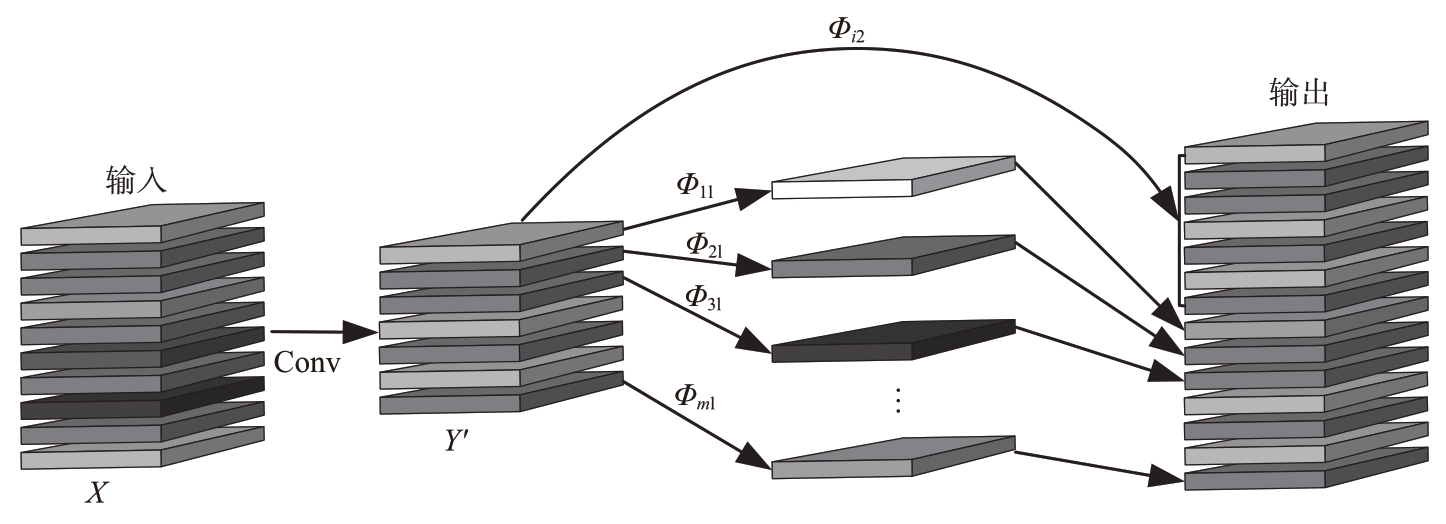

深度卷积神经网络由大量的卷积运算组成,需要消耗大量的计算资源,虽然目前存在一些轻量化网络,如MobileNet[16]引入了深度可分离卷积减少了网络模型的参数,但网络中剩余的1×1的卷积操作仍占用大量的计算资源。由于训练好的神经网络的中间特征图存在冗余,即存在卷积层的一些输出特征图相似的情况[17],卷积层的输出特征图通常较为冗余,其中特征图一些彼此相似,所以采用Ghost模块替换网络学习单元中1×1的卷积操作。首先使用普通的卷积操作生成部分固有的特征图Y':

为了便于理解和计算,公式(12)忽略了偏置项B,Y'∈ℝh'×w'×m,F'∈ℝl×g×g×m 为生成固有特征图所采用的卷积核,m指输出固有特征图的通道数且m ≤n。对Y'中的每一张特征图y'i 进行廉价的线性操作得到其幻象特征图:

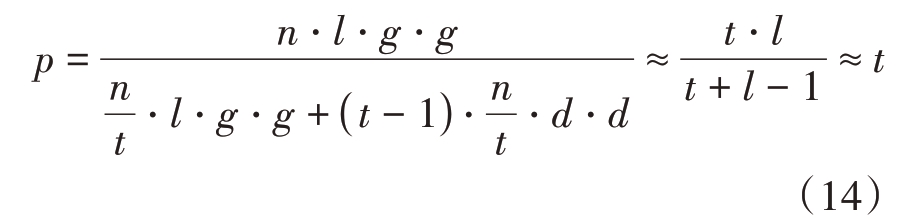

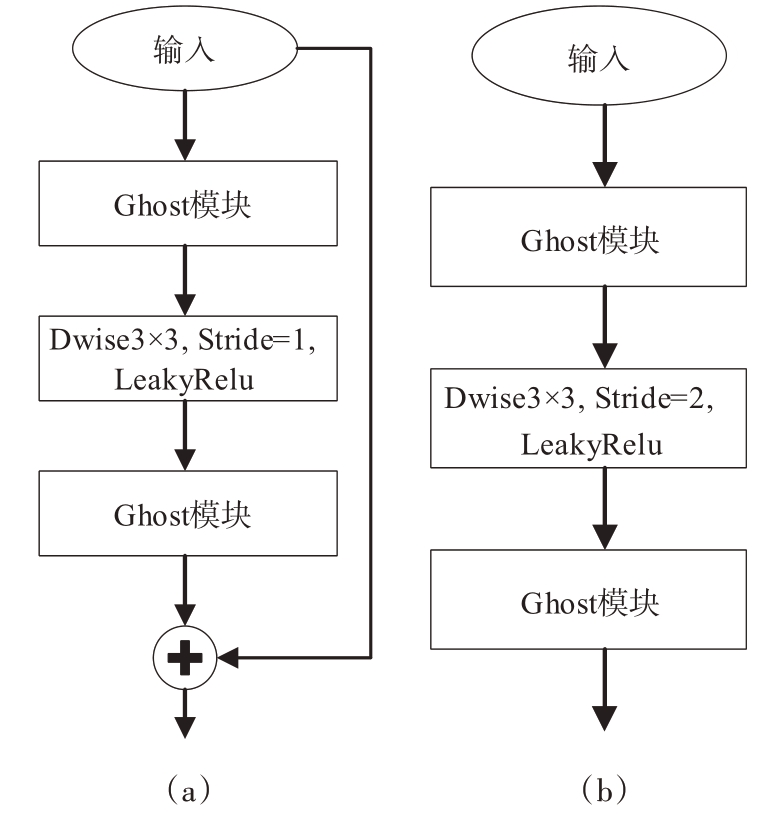

式中:yij 表示幻象特征图,i=1,…,m,j=1,…,t;Φij表示第i 张固有特征图y'i 的第j 次线性映射;t 为在固有特征图的基础上进行线性映射所生成幻象特征图的个数,即固有特征图y'i 可以有多个幻象特征图,最后一张幻象特征图为保留其本身特征的身份映射。图4 为y'i 具有两个幻象特征图时Ghost模块结构,映射操作Φ11,Φ21,…,Φm1 通常采用卷积核大小为d × d 的深度可分离卷积操作,并且深度可分离卷积的卷积核大小通常与普通卷积的卷积核大小相同,Φi2 为保留固有特征图本身特征的身份映射,将所有特征图拼接即得到模块的输出数据。采用Ghost 模块与采用传统卷积的理论参数量压缩比p可表示为

图4 Ghost模块结构

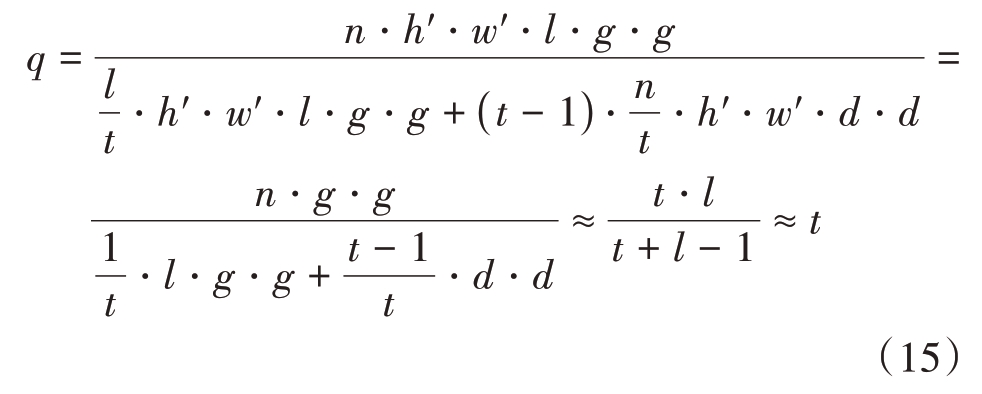

式中,t ≪l。同样,采用Ghost 模块与采用传统卷积的理论浮点数运算量q可表示为

从公式(14)和(15)可以看出,使用Ghost 模块与传统卷积相比,参数量和浮点运算数量均压缩了t 倍,所以本文使用Ghost 模块代替MobileNet 学习单元中的普通卷积,达到了减少网络模型参数量和运算量的效果,将改进后的学习单元命名为G-Bottleneck。G-Bottleneck 的结构如图5 所示,输入图像特征首先经过Ghost 模块进行升维操作,产生多个通道,然后再对升维之后的数据进行深度可分离卷积操作,其中深度可分离卷积的卷积核大小通常为3×3,最后再使用Ghost 模块对数据进行降维操作得到学习单元的输出特征。若深度可分离卷积操作的步长为1,则学习单元带有残差连接,如图5(a)所示,若深度可分离卷积操作的步长为2,则学习单元没有残差连接,如图5(b)所示。

图5 G-Bottleneck结构

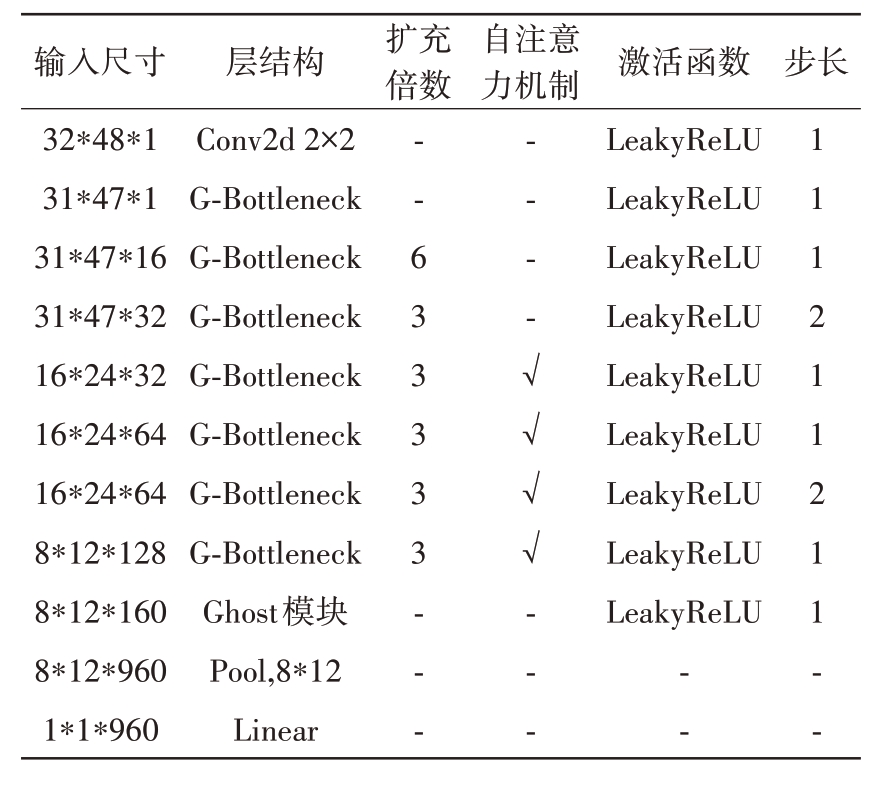

由于雷达RD图像较光学图像分辨率较低、图像尺寸较小、特征较为简单,所以本文在MobileNetV3[18]的基础上对网络结构进行删减,并将删减过后的网络命名为MobileNet11。本文提出的G-MobileNet网络结构见表1,G-MobileNet与MobileNet11 网络结构相同,但G-MobileNet 采用G-Bottleneck 替换了MobileNet11 网络结构中的Bottleneck,使用Ghost模块替换了平均池化前的卷积操作。

表1 G-MobileNet结构

输入尺寸32*48*1 31*47*1 31*47*16 31*47*32 16*24*32 16*24*64 16*24*64 8*12*128 8*12*160 8*12*960 1*1*960层结构Conv2d 2×2 G-Bottleneck G-Bottleneck G-Bottleneck G-Bottleneck G-Bottleneck G-Bottleneck G-Bottleneck Ghost模块Pool,8*12 Linear扩充倍数自注意力机制步长--633333-------√√√√---激活函数LeakyReLU LeakyReLU LeakyReLU LeakyReLU LeakyReLU LeakyReLU LeakyReLU LeakyReLU LeakyReLU--111211211--

3 实验分析

3.1 实测数据采集及处理

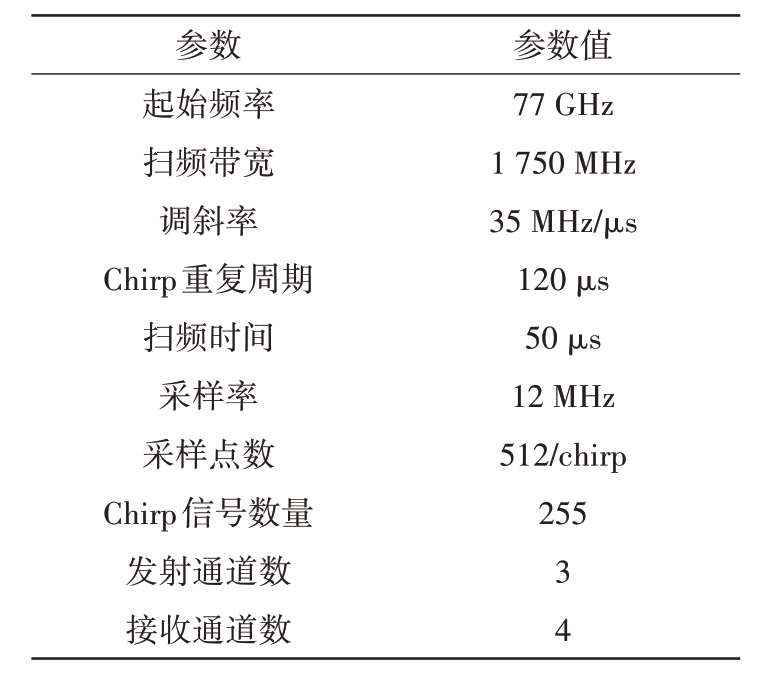

本文采用德州仪器(Texas Instruments, TI)公司生产的AWR1843BOOST 雷达板和DCA1000-EVM 实时数据采集板完成目标回波数据的采集,通过60 针高密度连接线将二者进行连接,通过USB 数据线进行控制数据的传输,使用TI 公司开发的mmWave Studio 平台配置毫米波雷达传感器,并且通过以太网将DCA1000EVM 采集到的原始雷达数据传输到PC端。雷达主要配置参数见表2。

表2 雷达参数配置表

参数起始频率扫频带宽调斜率Chirp重复周期扫频时间采样率采样点数Chirp信号数量发射通道数接收通道数参数值77 GHz 1 750 MHz 35 MHz/µs 120µs 50µs 12 MHz 512/chirp 255 34

图6 为目标回波的采集场景,在距离雷达3~30 m 的距离范围内共有行人、自行车、汽车三类目标分别驶向和驶离雷达。为了确保目标回波特征的多样性,对于每类目标均选取了多个目标进行测量。其中,对5 个身高分布在163~182 cm 内的行人进行测量,采集了16组数据;对城市车和山地车两种不同类型的自行车采集了15 组数据;对轿车和SUV 车型两种车型进行测量,共采集了2 组数据。

图6 数据采集场景

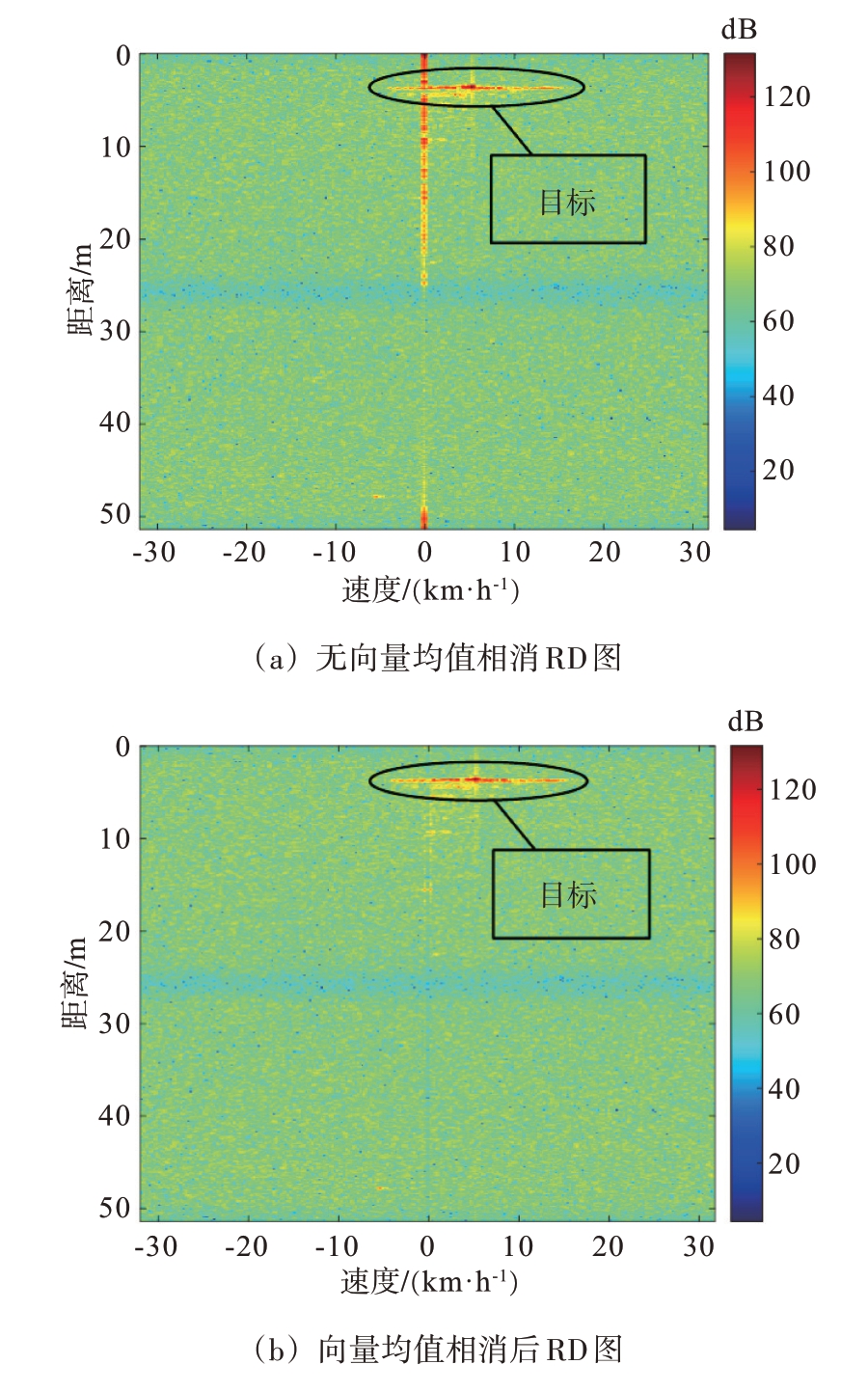

图7 展示了对雷达回波数据未进行向量均值相消处理和向量均值相消处理得到的雷达RD 图像。从图中可以看出,目标的速度存在扩展,这是由于目标的不同部位的运动产生了不同的微动多普勒效应,具有不同的速度分量。从图7(a)可以看出,在未对雷达回波信号进行向量均值相消处理时,当目标速度较小或者目标速度扩展较大时,静止目标的回波信号会对目标的多普勒特征产生干扰。图7(b)为对目标回波进行向量均值相消后的雷达目标RD图像,对比图7(a)和图7(b)可以看出,本文采用的信号处理流程能够抑制静止杂波对目标多普勒特征的干扰,同时保留目标的多普勒特征和微多普勒特征。对所有雷达回波数据进行处理,最终共得到5 920 张行人雷达RD 图像、5 004 张自行车雷达RD 图像和180 张汽车RD图像。

图7 雷达RD图像

3.2 目标分类网络模型验证

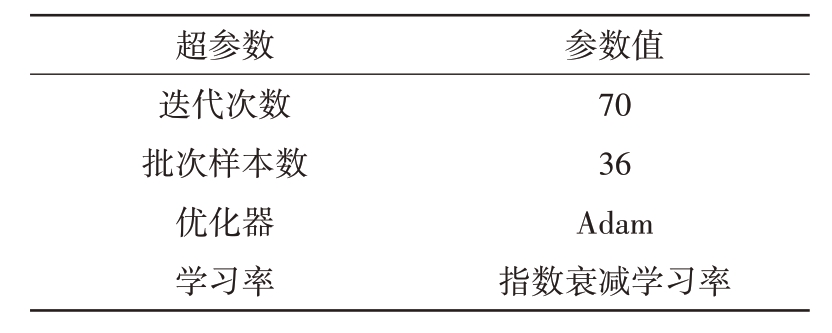

实验硬件平台为CPU:Intel i5-12400F;内存:16 GB;GPU:NVIDIA GeForce GTX1660Spuer 6 GB。将雷达RD图像随机打乱后按照4∶1的比例划分为训练集和测试集。采用Pytorch1.12.1 深度学习开源框架,在64 位Windows10 操作系统下,通过Python3.8 编程语言搭建G-MobileNet 神经网络,按照表3 中的参数对G-MobileNet 网络进行设置。使用训练集和测试集对网络进行训练及测试。

表3 G-MobileNet网络参数配置

超参数迭代次数批次样本数优化器学习率参数值70 36 Adam指数衰减学习率

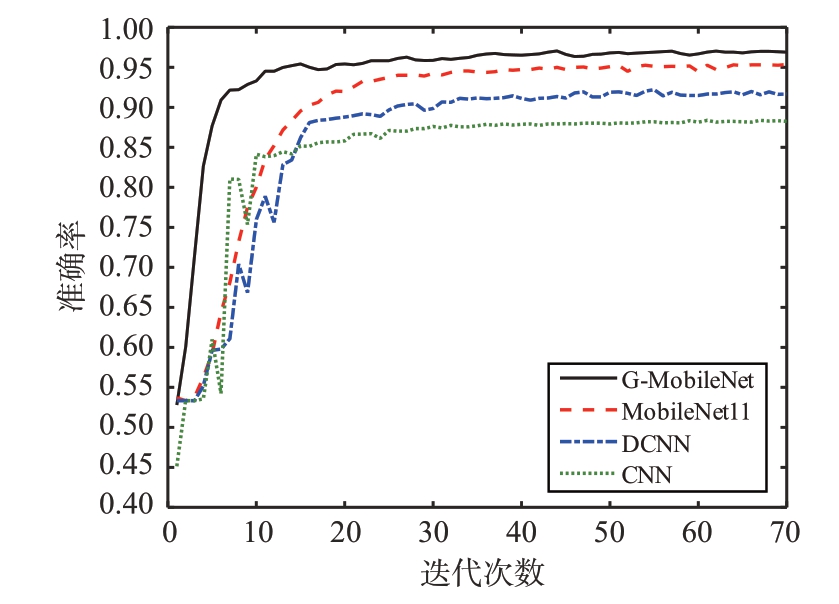

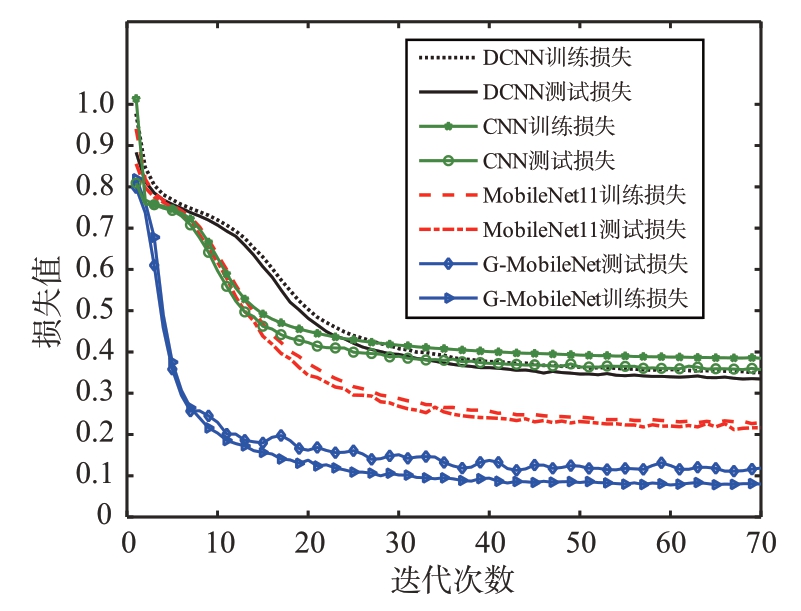

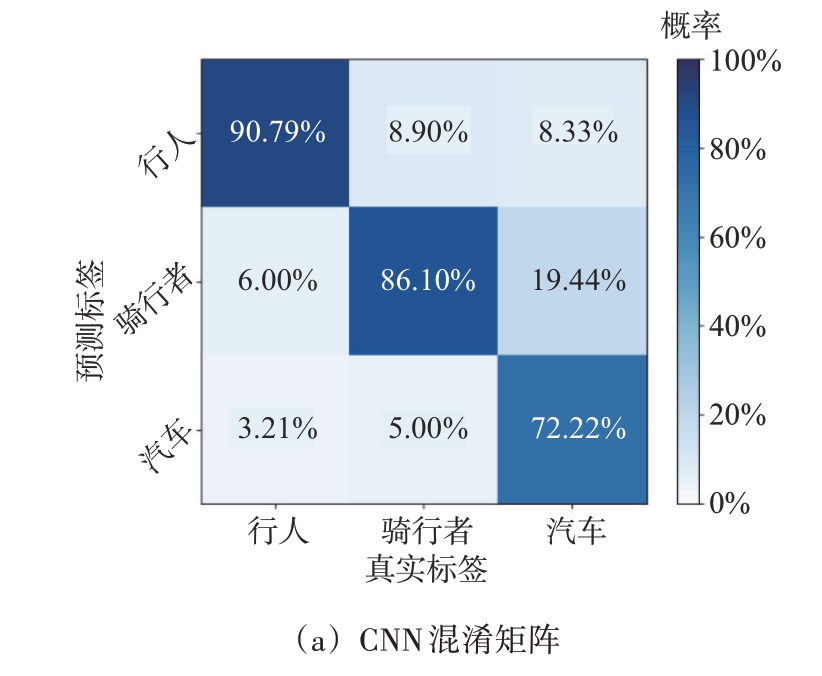

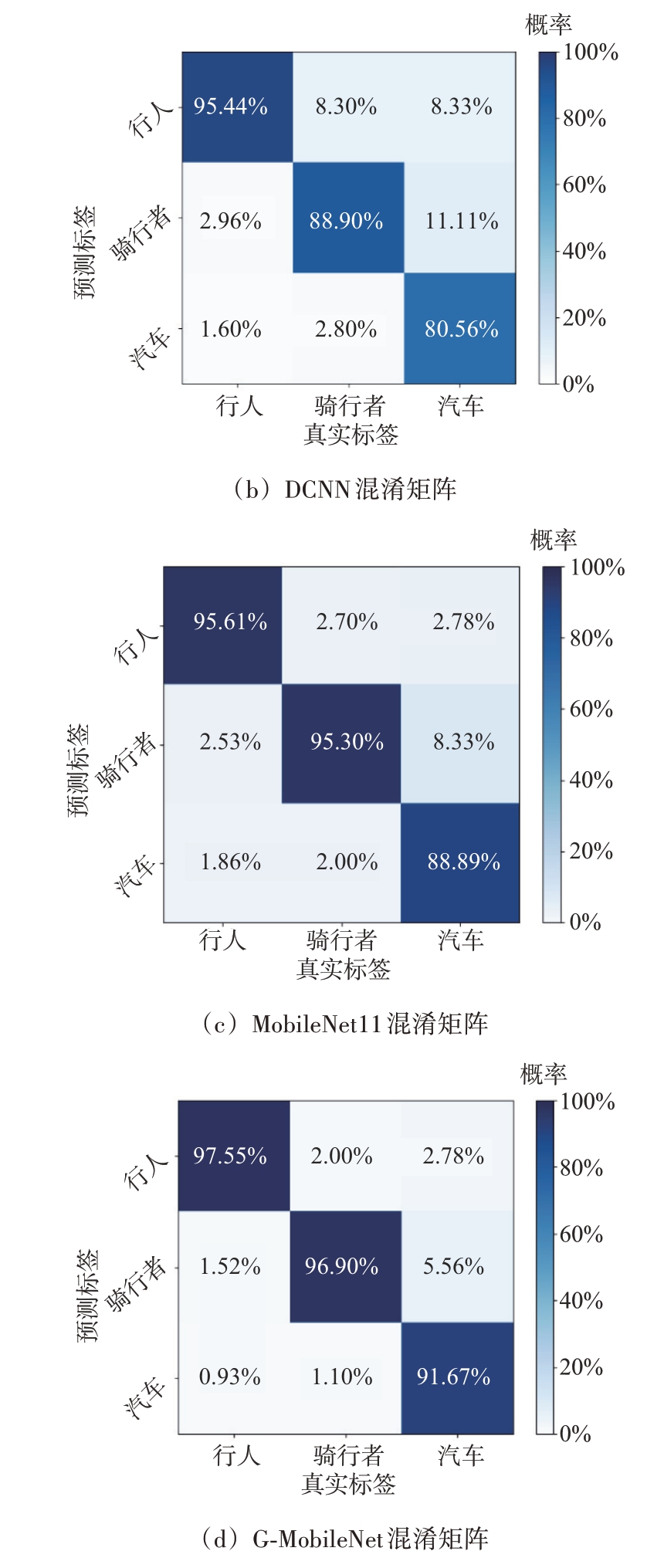

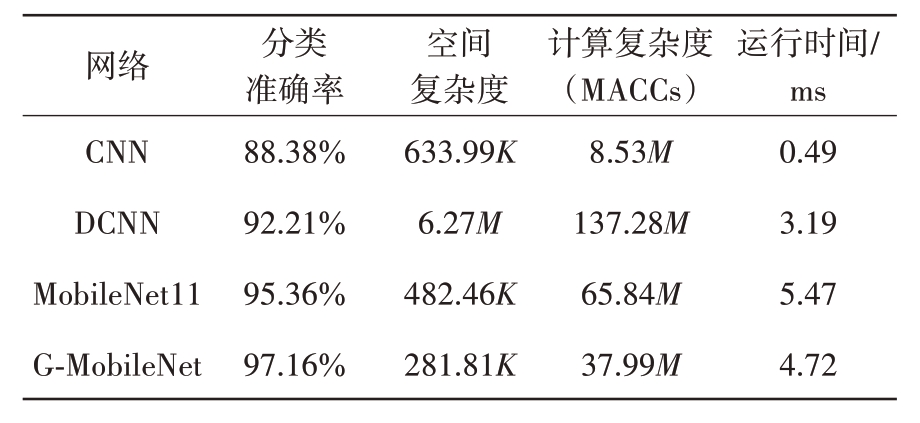

本文选取了CNN、DCNN 和MobileNet11 作为对比网络,图8 和图9 分别为网络测试准确率曲线和损失曲线,网络的准确率曲线趋于稳定并且训练损失值和测试损失值下降趋势保持一致,网络模型训练过程中没有产生过拟合的现象,与CNN、DCNN 和MobileNet11对比可知,本文设计的G-MobileNet分类准确率高于对比网络。

图8 测试准确率曲线图

图9 损失曲线图

图10(a)、(b)、(c)、(d)分别展示了CNN、DCNN、MobileNet11 和G-MobileNet 的分类混淆矩阵。从图中可以看出,G-MobileNet 对行人、骑行者、汽车的单类识别准确率分别为97.55%、96.90% 和91.67%,均高于对比网络。

图10 混淆矩阵

本文分别从分类准确率、空间复杂度、时间复杂度和网络对RD图像的推理时间4个方面进行了对比分析。如表4 所示,由于CNN 网络结构相较于其他3种网络结构较为简单,所以其计算复杂度较低,网络运行时间较短,但是CNN 网络分类准确率很低,仅有88.38%。DCNN 网络深度比MobileNet11 和G-MobileNet 的网络深度更小,计算机运行DCNN 时CPU 访问内存的次数和耗时均减少,所以DCNN的运行时间比MobileNet11和G-MobileNet 的运行时间短,但DCNN 的空间复杂度较大,即参数量较多,需要较大的存储空间,计算复杂度较高,即浮点运算数量较多,网络运行时需要占用大量的内存,且分类准确率较低。本文提出的G-MobileNet 分类准确率高于对比网络DCNN 和MobileNet11 分类准确率,并且其空间复杂度较DCNN 和MobileNet11 分别减少了95.51% 和41.59%,可节约大量存储模型所需的内存空间,其计算复杂度分别比DCNN 和MobileNet11 减少了72.33%和42.3%,减少了网络运行时占用的运行内存。

表4 网络模型对比

网络CNN DCNN MobileNet11 G-MobileNet分类准确率88.38%92.21%95.36%97.16%空间复杂度633.99K 6.27M 482.46K 281.81K计算复杂度(MACCs)8.53M 137.28M 65.84M 37.99M运行时间/ms 0.49 3.19 5.47 4.72

4 结束语

本文提出了一种车载毫米波雷达目标分类方法,首先引入了向量均值相消算法对目标回波进行处理,再进行二维FFT 得到目标的RD 图像,最后设计G-MobileNet 轻量化网络对RD 图像进行特征的提取和分类。实测数据处理结果表明,本文提出的信号处理方法能够消除静止杂波对目标多普勒特征的干扰,并且保留了目标完整的多普勒及微动多普勒特征,实现了对行人、骑行者和汽车三类目标的分类;本文设计的轻量化网络具有较高的分类准确率,同时具有空间复杂度和计算复杂度低的特点,能够为车载系统节省大量的储存空间和运行内存。

[1]赵海涛,程慧玲,丁仪,等.基于深度学习的车联边缘网络交通事故风险预测算法研究[J].电子与信息学报,2020,42(1):50-57.

[2]LI Z, LIU P, MAO B, et al. Spatiotemporal Analysis of Traffic Accidents in China: A Review[J]. Sustainability,2020,12(11):4686.

[3]YUE Y,LIU H,WANG Y,et al.Real-Time Scene Perception for Autonomous Driving:A Survey[J].IEEE Trans on Intelligent Transportation Systems, 2021, 22(2):1123-1141.

[4]PATOLE S M, TORLAK M, WANG D, et al. Automotive Radars: A Review of Signal Processing Techniques[J].IEEE Signal Processing Magazine, 2017, 34(2):22-35.

[5]ENGELS F, HEIDENREICH P, WINTERMANTEL M, et al. Automotive Radar Signal Processing: Research Directions and Practical Challenges[J]. IEEE Journal of Selected Topics in Signal Processing, 2021, 15(4):865-878.

[6]张群,胡健,罗迎,等.微动目标雷达特征提取、成像与识别研究进展[J].雷达学报,2018,7(5):531-547.

[7]丁晨旭,张远辉,孙哲涛,等.基于FMCW 雷达的人体复杂动作识别[J].雷达科学与技术,2020,18(6):584-590.

[8]YAN X, XU C, CAO Z, et al. Classification of Automotive Radar Targets Based on Micro-Doppler Features Using a Convolutional Neural Network[J].IEEE Trans on Vehicular Technology,2021,69(5):4981-4989.

[9]ZHANG Wei, LI Huiyong, SUN Guohao, et al. Enhanced Detection of Doppler-Spread Targets for FMCW Radar[J].IEEE Trans on Aerospace and Electronic Systems, 2019,55(4):2066-2078.

[10]黎耿,黎向阳,张军.要地警戒雷达目标特征提取及分类研究[J].雷达科学与技术,2016,14(2):127-133.

[11]PATEL K, RAMBACH K, VISENTIN T, et al. Deep Learning-Based Object Classification on Automotive Radar Spectra[C]//2019 IEEE Radar Conference, Oklahoma City,OK,USA:IEEE,2019:1-6.

[12]GUPTA S, RAI P K, KUMAR A, et al. Target Classification by mmWave FMCW Radars Using Machine Learning on Range-Angle Images[J]. IEEE Sensors Journal,2021,21(18):19993-20001.

[13]PEREZ R,SCHUBERT F,RASSHOFER R,et al.Single-Frame Vulnerable Road Users Classification with a 77 GHz FMCW Radar Sensor and a Convolutional Neural Network[C]//2018 19th International Radar Symposium,Bonn,Germany:IEEE,2018:1-10.

[14]KIM Y, ALNUJAIM I, YOU S, et al. Human Detection with Range-Doppler Signatures Using 3D Convolutional Neural Networks[C]// IEEE International Geoscience and Remote Sensing Symposium,USA:IEEE,2020:2440-2442.

[15]KIM Y, ALNUJAIM I, YOU S, et al. Human Detection Based on Time-Varying Signature on Range-Doppler Diagram Using Deep Neural Networks[J].IEEE Geoscience and Remote Sensing Letters, 2021, 18(3):426-430.

[16]SANDLER M, HOWARD A, ZHU M, et al. Mobilenetv2:Inverted Residuals and Linear Bottlenecks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA: IEEE,2018:4510-4520.

[17]HAN Kai,WANG Yunhe,TIAN Qi,et al.Ghostnet:More Features from Cheap Operations[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,Seattle,WA,USA:IEEE,2020:1580-1589.

[18]HOWARD A,SANDLER M,CHU G,et al.Searching for Mobilenetv3[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision, Seoul, Korea(South):IEEE,2019:1314-1324.